Ang pangangatuwirang kapangyarihan ng AI: Hamon GPT?

Sa mga nagdaang taon, ang pamayanan ng AI ay nabighani sa mga kamangha -manghang mga nagawa ng mga malalaking modelo ng wika (LLM). Orihinal na nilikha para sa pagproseso ng natural na wika, ang mga modelong ito ay nagbago sa sopistikadong mga tool sa pangangatuwiran na may kakayahang malutas ang masalimuot na mga problema sa isang hakbang-hakbang na proseso ng pag-iisip na katulad ng pangangatuwiran ng tao. Gayunpaman, sa kabila ng kanilang mga advanced na kakayahan, ang mga LLM ay may mga kilalang drawback, kabilang ang mga mataas na gastos sa computational at mabagal na bilis ng paglawak, na ginagawang hindi gaanong magagawa para sa mga application na real-world sa mga setting na limitado sa mapagkukunan tulad ng mga mobile device o gilid ng computing. Ito ay nagdulot ng isang masigasig na interes sa pagbuo ng mas maliit, mas mahusay na mga modelo na maaaring maghatid ng maihahambing na mga kakayahan sa pangangatuwiran habang binabawasan ang mga gastos at mga kahilingan sa mapagkukunan. Ang artikulong ito ay sumasalamin sa paglitaw ng mga maliliit na modelo ng pangangatuwiran na ito, paggalugad ng kanilang potensyal, mga hamon, at ang hinaharap na mga implikasyon para sa landscape ng AI.

Isang paglipat sa pananaw

Para sa isang makabuluhang panahon sa kamakailang kasaysayan ng AI, ang patlang ay sumunod sa prinsipyo ng "mga batas sa pag -scale," na kung saan ang pag -post na ang pagganap ay nagpapabuti nang hulaan bilang data, pagkalkula ng lakas, at pagtaas ng laki ng modelo. Habang ang pamamaraang ito ay talagang gumawa ng mga makapangyarihang modelo, humantong din ito sa malaking trade-off, tulad ng mataas na gastos sa imprastraktura, epekto sa kapaligiran, at mga isyu sa latency. Hindi lahat ng mga aplikasyon ay nangangailangan ng buong kakayahan ng napakalaking mga modelo na may daan -daang bilyun -bilyong mga parameter. Sa maraming mga praktikal na senaryo-tulad ng mga katulong na on-device, pangangalaga sa kalusugan, at edukasyon-ang mga modelo ng mas maliit ay maaaring makamit ang maihahambing na mga kinalabasan, kung maaari silang mabisa nang maayos.

Pag -unawa sa pangangatuwiran sa AI

Ang pangangatuwiran sa AI ay sumasaklaw sa kakayahan ng isang modelo na sundin ang mga lohikal na pagkakasunud -sunod, maunawaan ang sanhi at epekto, bawasan ang mga implikasyon, mga hakbang sa pamamaraan ng plano, at kilalanin ang mga pagkakasalungatan. Para sa mga modelo ng wika, ito ay nagsasangkot hindi lamang pagkuha ng impormasyon ngunit din ang pagmamanipula at pagbawas ng data sa pamamagitan ng isang nakabalangkas, sunud-sunod na diskarte. Ang pagkamit ng antas ng pangangatuwiran na ito ay karaniwang nangangailangan ng fine-tuning LLMS upang maisagawa ang multi-step na pangangatuwiran bago maabot ang isang konklusyon. Habang epektibo, ang mga pamamaraan na ito ay masinsinang mapagkukunan at maaaring maging mabagal at magastos upang mag-deploy, na nagtaas ng mga alalahanin tungkol sa kanilang pag-access at epekto sa kapaligiran.

Pag -unawa sa mga maliliit na modelo ng pangangatuwiran

Ang mga maliliit na modelo ng pangangatuwiran ay naglalayong kopyahin ang mga kakayahan sa pangangatuwiran ng mga malalaking modelo ngunit may higit na kahusayan sa mga tuntunin ng computational power, paggamit ng memorya, at latency. Ang mga modelong ito ay madalas na gumagamit ng isang pamamaraan na kilala bilang pag-distill ng kaalaman, kung saan ang isang mas maliit na modelo (ang "mag-aaral") ay natututo mula sa isang mas malaki, pre-sanay na modelo (ang "guro"). Ang proseso ng pag -distillation ay nagsasangkot ng pagsasanay sa mas maliit na modelo sa data na nabuo ng mas malaki, na naglalayong ilipat ang kakayahan sa pangangatuwiran. Ang modelo ng mag-aaral ay pagkatapos ay maayos na nakatutok upang mapahusay ang pagganap nito. Sa ilang mga pagkakataon, ang pag-aaral ng pampalakas na may dalubhasang mga pag-andar ng gantimpala na tiyak na domain ay ginagamit upang higit na pinuhin ang kakayahan ng modelo na magsagawa ng pangangatuwiran na tiyak na gawain.

Ang pagtaas at pagsulong ng mga maliliit na modelo ng pangangatuwiran

Ang isang mahalagang sandali sa pagbuo ng mga maliliit na modelo ng pangangatuwiran ay minarkahan ng pagpapalabas ng Deepseek-R1. Bihasa sa isang medyo katamtaman na kumpol ng mga mas matandang GPU, nakamit ng Deepseek-R1 ang mga antas ng pagganap na maihahambing sa mas malaking mga modelo tulad ng OpenAi's O1 sa mga benchmark tulad ng MMLU at GSM-8K. Ang tagumpay na ito ay nag -udyok sa isang muling pagsusuri ng tradisyunal na diskarte sa pag -scale, na ipinapalagay na ang mga mas malalaking modelo ay likas na nakahihigit.

Ang tagumpay ng DeepSeek-R1 ay maaaring maiugnay sa makabagong proseso ng pagsasanay, na pinagsama ang malakihang pag-aaral ng pampalakas nang hindi umaasa sa pinangangasiwaan na pag-aayos sa mga unang yugto. Ang makabagong ito ay humantong sa paglikha ng Deepseek-R1-Zero, isang modelo na nagpakita ng mga kahanga-hangang kakayahan sa pangangatuwiran kumpara sa mga malalaking modelo ng pangangatuwiran. Ang mga karagdagang pagpapahusay, tulad ng paggamit ng cold-start data, ay nagpabuti ng pagkakaugnay ng modelo at pagpapatupad ng gawain, lalo na sa mga lugar tulad ng matematika at coding.

Bilang karagdagan, ang mga diskarte sa distillation ay napatunayan na nakatulong sa pagbuo ng mas maliit, mas mahusay na mga modelo mula sa mas malalaking. Halimbawa, ang Deepseek ay naglabas ng mga distilled na bersyon ng mga modelo nito, na may sukat mula sa 1.5 bilyon hanggang 70 bilyong mga parameter. Gamit ang mga modelong ito, sinanay ng mga mananaliksik ang isang makabuluhang mas maliit na modelo, Deepseek-R1-distill-Qwen-32B, na kung saan ay naipalabas ang OpenAi's O1-Mini sa iba't ibang mga benchmark. Ang mga modelong ito ay nai -deploy ngayon sa karaniwang hardware, na ginagawang mas mabubuhay na pagpipilian para sa isang malawak na hanay ng mga aplikasyon.

Maaari bang tumugma ang mga maliliit na modelo ng GPT-level na pangangatuwiran?

Upang matukoy kung ang mga maliliit na modelo ng pangangatuwiran (SRMS) ay maaaring tumugma sa pangangatuwiran na kapangyarihan ng mga malalaking modelo (LRM) tulad ng GPT, mahalaga na suriin ang kanilang pagganap sa mga karaniwang benchmark. Halimbawa, ang modelo ng DeepSeek-R1 ay nakapuntos sa paligid ng 0.844 sa pagsubok ng MMLU, na maihahambing sa mas malaking mga modelo tulad ng O1. Sa dataset ng GSM-8K, na nakatuon sa matematika ng grade-school, ang distilled model ng DeepSeek-R1 ay nakamit ang top-tier na pagganap, na lumampas sa parehong O1 at O1-Mini.

Sa mga gawain ng coding, tulad ng mga nasa LiveCodebench at Codeforces, ang mga distilled models ng DeepSeek-R1 ay gumanap nang katulad sa O1-Mini at GPT-4O, na nagpapakita ng malakas na kakayahan sa pangangatuwiran sa programming. Gayunpaman, ang mga mas malalaking modelo ay mayroon pa ring kalamangan sa mga gawain na nangangailangan ng mas malawak na pag-unawa sa wika o paghawak ng mahabang mga bintana ng konteksto, dahil ang mas maliit na mga modelo ay may posibilidad na maging mas tiyak na gawain.

Sa kabila ng kanilang mga lakas, ang mga maliliit na modelo ay maaaring makipaglaban sa pinalawig na mga gawain sa pangangatuwiran o kapag nahaharap sa data ng pamamahagi. Halimbawa, sa mga simulation ng chess ng LLM, ang Deepseek-R1 ay gumawa ng higit pang mga pagkakamali kaysa sa mas malaking mga modelo, na nagpapahiwatig ng mga limitasyon sa kakayahang mapanatili ang pokus at kawastuhan sa mga pinalawig na panahon.

Mga trade-off at praktikal na implikasyon

Ang mga trade-off sa pagitan ng laki ng modelo at pagganap ay kritikal kapag inihahambing ang mga SRM sa GPT-level LRMS. Ang mas maliit na mga modelo ay nangangailangan ng mas kaunting memorya at computational na kapangyarihan, na ginagawang perpekto para sa mga aparato sa gilid, mobile app, o mga sitwasyon kung saan kinakailangan ang offline na pagkilala. Ang kahusayan na ito ay nagreresulta sa mas mababang mga gastos sa pagpapatakbo, na may mga modelo tulad ng DeepSeek-R1 na hanggang sa 96% na mas mura upang tumakbo kaysa sa mas malaking mga modelo tulad ng O1.

Gayunpaman, ang mga nakuha na kahusayan na ito ay may ilang mga kompromiso. Ang mas maliit na mga modelo ay karaniwang pinong nakatutok para sa mga tiyak na gawain, na maaaring limitahan ang kanilang kakayahang magamit kumpara sa mas malalaking modelo. Halimbawa, habang ang DeepSeek-R1 ay higit sa matematika at coding, kulang ito ng mga kakayahan ng multimodal, tulad ng kakayahang bigyang kahulugan ang mga imahe, na maaaring hawakan ng mga mas malalaking modelo tulad ng GPT-4O.

Sa kabila ng mga limitasyong ito, ang mga praktikal na aplikasyon ng mga maliliit na modelo ng pangangatuwiran ay malawak. Sa pangangalagang pangkalusugan, maaari silang mag -kapangyarihan ng mga tool sa diagnostic na nagsuri ng data ng medikal sa mga karaniwang server ng ospital. Sa edukasyon, maaari silang magamit upang makabuo ng mga isinapersonal na mga sistema ng pagtuturo, na nagbibigay ng sunud-sunod na puna sa mga mag-aaral. Sa pang -agham na pananaliksik, maaari silang makatulong sa pagsusuri ng data at pagsubok ng hypothesis sa mga patlang tulad ng matematika at pisika. Ang open-source na likas na katangian ng mga modelo tulad ng Deepseek-R1 ay nagtataguyod din ng pakikipagtulungan at hinimok ang pag-access sa AI, na nagpapagana ng mas maliit na mga organisasyon na makinabang mula sa mga advanced na teknolohiya.

Ang ilalim na linya

Ang ebolusyon ng mga modelo ng wika sa mas maliit na mga modelo ng pangangatuwiran ay kumakatawan sa isang makabuluhang pagsulong sa AI. Habang ang mga modelong ito ay maaaring hindi pa ganap na tumutugma sa malawak na kakayahan ng mga malalaking modelo ng wika, nag-aalok sila ng mga pangunahing pakinabang sa kahusayan, pagiging epektibo, at pag-access. Sa pamamagitan ng kapansin-pansin na balanse sa pagitan ng pangangatuwiran na kapangyarihan at kahusayan ng mapagkukunan, ang mas maliit na mga modelo ay naghanda upang maglaro ng isang mahalagang papel sa iba't ibang mga aplikasyon, na ginagawang mas praktikal at napapanatiling AI ang paggamit ng real-world.

-

1

Stardew Valley: Isang Kumpletong Gabay sa Mga Enchantment at Weapon Forging

Jan 07,2025

-

2

Roblox UGC Limited Codes Inilabas para sa Enero 2025

Jan 06,2025

-

3

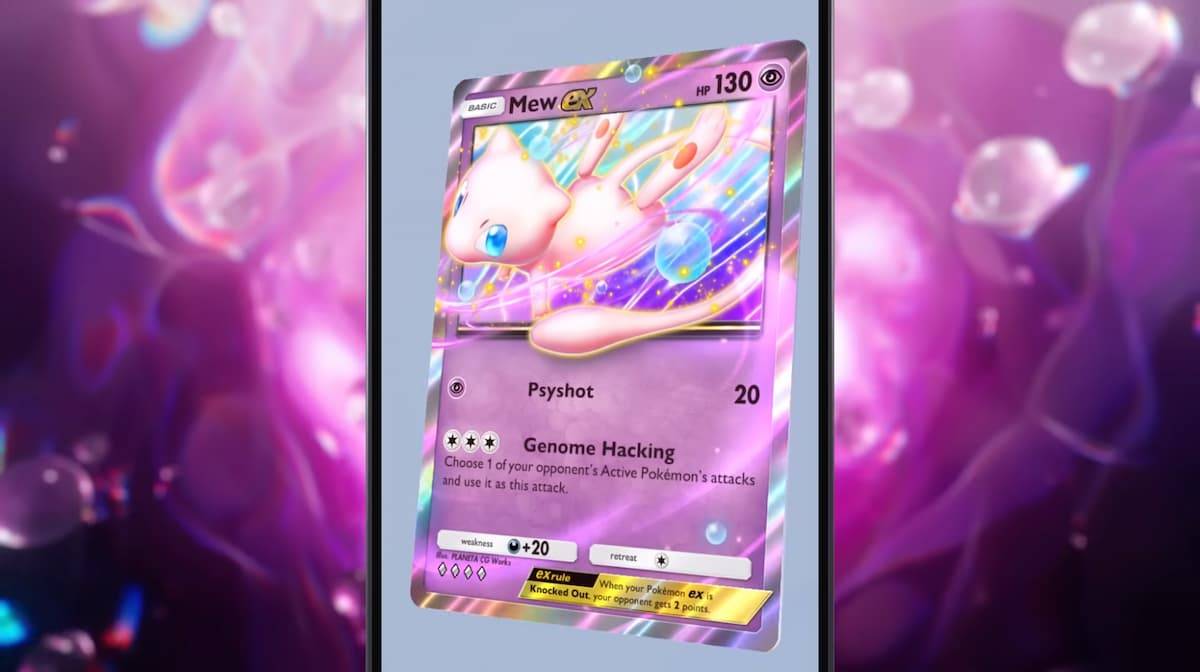

Pokémon TCG Pocket: Nalutas ang Error 102 sa Pag-troubleshoot

Jan 08,2025

-

4

Blue Archive Inilabas ang Cyber New Year March Event

Dec 19,2024

-

5

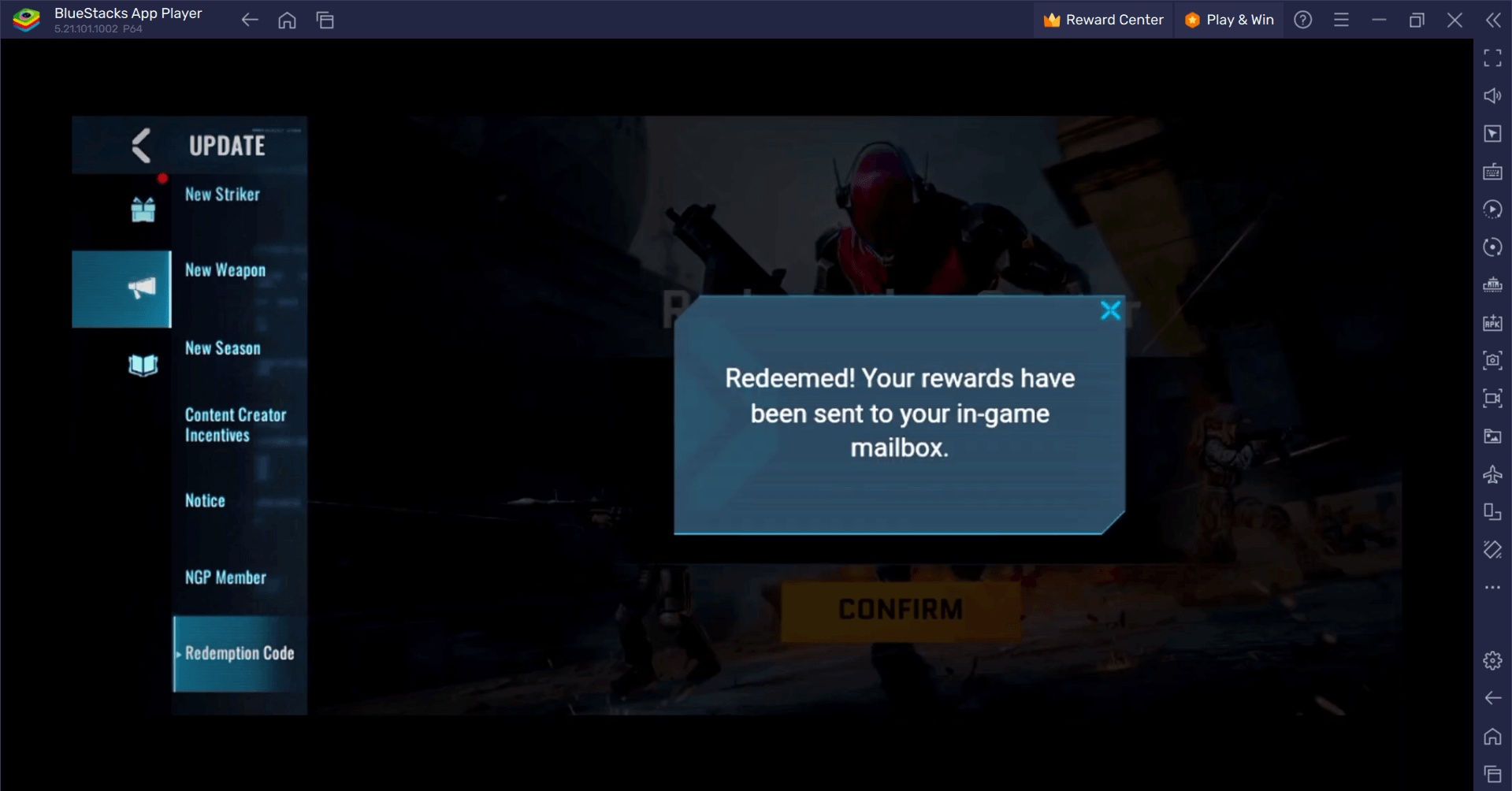

Blood Strike - Lahat ng Working Redeem Code noong Enero 2025

Jan 08,2025

-

6

Cyber Quest: Makisali sa Mapang-akit na Mga Labanan sa Card sa Android

Dec 19,2024

-

7

![ROBLOX Forsaken Character Tier List [na -update] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

ROBLOX Forsaken Character Tier List [na -update] (2025)

Mar 17,2025

-

8

Sony Nagpapakita ng Bago Midnight Black PS5 Accessories

Jan 08,2025

-

9

Nag-drop si Bart Bonte ng Bagong Palaisipan Mister Antonio Kung Saan Ka Maglaro ng Fetch 'For' a Cat!

Dec 18,2024

-

10

Roblox: RIVALS Codes (Enero 2025)

Jan 07,2025

-

I-download

Random fap scene

Kaswal / 20.10M

Update: Dec 26,2024

-

I-download

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

Kaswal / 486.00M

Update: Dec 17,2024

-

I-download

Arceus X script

Personalization / 127.00M

Update: Oct 21,2021

-

4

A Simple Life with My Unobtrusive Sister

-

5

Ben 10 A day with Gwen

-

6

A Wife And Mother

-

7

Permit Deny

-

8

Oniga Town of the Dead

-

9

Cute Reapers in my Room Android

-

10

Piano White Go! - Piano Games Tiles