พลังการใช้เหตุผลของ AI ขนาดกะทัดรัด: ท้าทาย GPT?

ในช่วงไม่กี่ปีที่ผ่านมาชุมชน AI ได้รับความสนใจจากความสำเร็จที่น่าทึ่งของแบบจำลองภาษาขนาดใหญ่ (LLMs) เดิมทีสร้างขึ้นมาเพื่อการประมวลผลภาษาธรรมชาติแบบจำลองเหล่านี้ได้เปลี่ยนเป็นเครื่องมือให้เหตุผลที่ซับซ้อนที่สามารถแก้ปัญหาที่ซับซ้อนด้วยกระบวนการคิดทีละขั้นตอนคล้ายกับการใช้เหตุผลของมนุษย์ อย่างไรก็ตามแม้จะมีความสามารถขั้นสูงของพวกเขา LLM มีข้อเสียที่โดดเด่นรวมถึงค่าใช้จ่ายในการคำนวณที่สูงและความเร็วในการปรับใช้ที่ช้าซึ่งทำให้พวกเขาเป็นไปได้น้อยลงสำหรับแอปพลิเคชันในโลกแห่งความเป็นจริงในการตั้งค่าที่ จำกัด ทรัพยากรเช่นอุปกรณ์มือถือหรือการคำนวณขอบ สิ่งนี้ทำให้เกิดความสนใจอย่างมากในการพัฒนาโมเดลขนาดเล็กและมีประสิทธิภาพมากขึ้นซึ่งสามารถส่งมอบความสามารถในการใช้เหตุผลที่เทียบเคียงได้ในขณะที่ลดต้นทุนและความต้องการทรัพยากรให้น้อยที่สุด บทความนี้นำเสนอการเกิดขึ้นของรูปแบบการใช้เหตุผลขนาดเล็กเหล่านี้สำรวจศักยภาพความท้าทายและผลกระทบในอนาคตสำหรับภูมิทัศน์ AI

การเปลี่ยนแปลงในมุมมอง

สำหรับช่วงเวลาที่สำคัญในประวัติศาสตร์ล่าสุดของ AI สนามได้ปฏิบัติตามหลักการของ "กฎการปรับขนาด" ซึ่งวางตัวว่าประสิทธิภาพของโมเดลปรับปรุงการคาดการณ์เป็นข้อมูลการคำนวณพลังงานและการเพิ่มขนาดของแบบจำลอง ในขณะที่วิธีการนี้ได้สร้างแบบจำลองที่มีประสิทธิภาพ แต่ก็นำไปสู่การแลกเปลี่ยนจำนวนมากเช่นต้นทุนโครงสร้างพื้นฐานที่สูงผลกระทบต่อสิ่งแวดล้อมและปัญหาเวลาแฝง ไม่ใช่ทุกแอปพลิเคชันที่จำเป็นต่อความสามารถเต็มรูปแบบของโมเดลขนาดใหญ่ที่มีพารามิเตอร์หลายร้อยพันล้านพารามิเตอร์ ในสถานการณ์ที่ใช้งานได้หลายอย่างเช่นผู้ช่วยในอุปกรณ์การดูแลสุขภาพและการศึกษา-แบบจำลองที่มีการขายสามารถบรรลุผลลัพธ์ที่เทียบเท่าได้หากพวกเขาสามารถให้เหตุผลได้อย่างมีประสิทธิภาพ

ทำความเข้าใจการใช้เหตุผลใน AI

การใช้เหตุผลใน AI ครอบคลุมความสามารถของแบบจำลองในการติดตามลำดับเชิงตรรกะเข้าใจสาเหตุและผลกระทบสรุปผลกระทบขั้นตอนขั้นตอนการวางแผนและระบุความขัดแย้ง สำหรับแบบจำลองภาษาสิ่งนี้ไม่เพียง แต่จะดึงข้อมูล แต่ยังจัดการและอนุมานข้อมูลผ่านวิธีการแบบทีละขั้นตอนที่มีโครงสร้าง การบรรลุระดับการใช้เหตุผลนี้มักจะต้องมีการปรับจูน LLM เพื่อดำเนินการให้เหตุผลหลายขั้นตอนก่อนที่จะถึงข้อสรุป ในขณะที่มีประสิทธิภาพวิธีการเหล่านี้ใช้ทรัพยากรมากและอาจช้าและมีค่าใช้จ่ายสูงในการปรับใช้ทำให้เกิดความกังวลเกี่ยวกับการเข้าถึงและผลกระทบต่อสิ่งแวดล้อม

ทำความเข้าใจกับแบบจำลองการใช้เหตุผลขนาดเล็ก

แบบจำลองการใช้เหตุผลขนาดเล็กมีจุดมุ่งหมายเพื่อทำซ้ำความสามารถในการใช้เหตุผลของโมเดลขนาดใหญ่ แต่มีประสิทธิภาพมากขึ้นในแง่ของพลังงานการคำนวณการใช้หน่วยความจำและเวลาแฝง แบบจำลองเหล่านี้มักจะใช้เทคนิคที่เรียกว่าการกลั่นความรู้ซึ่งเป็นแบบจำลองขนาดเล็ก ("นักเรียน") เรียนรู้จากแบบจำลองขนาดใหญ่ที่ผ่านการฝึกอบรมมาก่อน ("ครู") กระบวนการกลั่นเกี่ยวข้องกับการฝึกอบรมโมเดลขนาดเล็กบนข้อมูลที่สร้างขึ้นโดยรุ่นที่ใหญ่กว่าโดยมีเป้าหมายเพื่อถ่ายโอนความสามารถในการให้เหตุผล แบบจำลองนักเรียนได้รับการปรับแต่งเพื่อเพิ่มประสิทธิภาพ ในบางกรณีการเรียนรู้การเสริมแรงด้วยฟังก์ชั่นการให้รางวัลเฉพาะโดเมนพิเศษถูกนำมาใช้เพื่อปรับแต่งความสามารถของโมเดลในการดำเนินการโดยเฉพาะงานโดยเฉพาะ

การเพิ่มขึ้นและความก้าวหน้าของรูปแบบการใช้เหตุผลขนาดเล็ก

ช่วงเวลาสำคัญในการพัฒนาแบบจำลองการใช้เหตุผลขนาดเล็กถูกทำเครื่องหมายด้วยการเปิดตัวของ Deepseek-R1 ได้รับการฝึกฝนเกี่ยวกับกลุ่ม GPU รุ่นเก่าที่ค่อนข้างเรียบง่าย Deepseek-R1 ประสบความสำเร็จในระดับประสิทธิภาพเทียบเท่ากับรุ่นที่มีขนาดใหญ่เช่น OpenAI OPE ของ OpenAI บนมาตรฐานเช่น MMLU และ GSM-8K ความสำเร็จนี้ได้กระตุ้นให้เกิดการประเมินวิธีการปรับขนาดแบบดั้งเดิมซึ่งสันนิษฐานว่าโมเดลขนาดใหญ่นั้นเหนือกว่าโดยเนื้อแท้

ความสำเร็จของ Deepseek-R1 สามารถนำมาประกอบกับกระบวนการฝึกอบรมที่เป็นนวัตกรรมซึ่งรวมการเรียนรู้การเสริมแรงขนาดใหญ่โดยไม่ต้องพึ่งพาการปรับแต่งการปรับแต่งในระยะแรก นวัตกรรมนี้นำไปสู่การสร้าง Deepseek-R1-Zero ซึ่งเป็นแบบจำลองที่แสดงความสามารถในการใช้เหตุผลที่น่าประทับใจเมื่อเทียบกับแบบจำลองการใช้เหตุผลขนาดใหญ่ การปรับปรุงเพิ่มเติมเช่นการใช้ข้อมูลเริ่มต้นเย็นปรับปรุงการเชื่อมโยงและการปฏิบัติงานของโมเดลโดยเฉพาะอย่างยิ่งในพื้นที่เช่นคณิตศาสตร์และการเข้ารหัส

นอกจากนี้เทคนิคการกลั่นได้พิสูจน์แล้วว่าเป็นเครื่องมือในการพัฒนาแบบจำลองขนาดเล็กและมีประสิทธิภาพมากขึ้นจากขนาดใหญ่ ตัวอย่างเช่น Deepseek ได้เปิดตัวโมเดลรุ่นกลั่นโดยมีขนาดตั้งแต่ 1.5 พันล้านถึง 70 พันล้านพารามิเตอร์ การใช้แบบจำลองเหล่านี้นักวิจัยได้ฝึกอบรมแบบจำลองที่เล็กกว่าอย่างมีนัยสำคัญ Deepseek-R1-Distill-Qwen-32B ซึ่งมีประสิทธิภาพสูงกว่า O1-MINI ของ OpenAI ในการวัดมาตรฐานต่างๆ ตอนนี้รุ่นเหล่านี้สามารถปรับใช้ได้บนฮาร์ดแวร์มาตรฐานทำให้เป็นตัวเลือกที่ทำงานได้มากขึ้นสำหรับแอปพลิเคชันที่หลากหลาย

รุ่นขนาดเล็กสามารถจับคู่เหตุผลระดับ GPT ได้หรือไม่?

ในการตรวจสอบว่าแบบจำลองการให้เหตุผลขนาดเล็ก (SRMS) สามารถจับคู่พลังการใช้เหตุผลของรุ่นขนาดใหญ่ (LRMS) เช่น GPT หรือไม่มันเป็นสิ่งสำคัญในการประเมินประสิทธิภาพของพวกเขาบนมาตรฐานมาตรฐาน ตัวอย่างเช่นโมเดล Deepseek-R1 ทำคะแนนประมาณ 0.844 ในการทดสอบ MMLU ซึ่งเทียบได้กับรุ่นที่ใหญ่กว่าเช่น O1 ในชุดข้อมูล GSM-8K ซึ่งมุ่งเน้นไปที่คณิตศาสตร์เกรดโรงเรียน Deepseek-R1 ของ Deepseek-R1 ได้รับประสิทธิภาพระดับสูงกว่า O1 และ O1-MINI

ในงานการเข้ารหัสเช่นใน LiveCodeBench และ CodeForces โมเดลกลั่น Deepseek-R1 ของ Deepseek-R1 นั้นทำเช่นเดียวกันกับ O1-MINI และ GPT-4O แสดงให้เห็นถึงความสามารถในการใช้เหตุผลที่แข็งแกร่งในการเขียนโปรแกรม อย่างไรก็ตามโมเดลขนาดใหญ่ยังคงมีข้อได้เปรียบในงานที่ต้องการความเข้าใจภาษาที่กว้างขึ้นหรือจัดการหน้าต่างบริบทที่ยาวนานเนื่องจากรุ่นที่เล็กกว่ามักจะมีความเฉพาะเจาะจงมากขึ้น

แม้จะมีจุดแข็งของพวกเขาโมเดลขนาดเล็กสามารถต่อสู้กับงานการใช้เหตุผลเพิ่มเติมหรือเมื่อต้องเผชิญกับข้อมูลนอกการกระจาย ตัวอย่างเช่นในการจำลองหมากรุก LLM Deepseek-R1 ทำผิดพลาดมากกว่าโมเดลขนาดใหญ่ซึ่งบ่งบอกถึงข้อ จำกัด ในความสามารถในการรักษาโฟกัสและความแม่นยำในช่วงเวลาที่ยาวนาน

การแลกเปลี่ยนและผลกระทบเชิงปฏิบัติ

การแลกเปลี่ยนระหว่างขนาดรุ่นและประสิทธิภาพมีความสำคัญเมื่อเปรียบเทียบ SRMS กับ LRM ระดับ GPT รุ่นขนาดเล็กต้องการหน่วยความจำน้อยลงและพลังการคำนวณทำให้เหมาะสำหรับอุปกรณ์ขอบแอพมือถือหรือสถานการณ์ที่จำเป็นต้องมีการอนุมานออฟไลน์ ประสิทธิภาพนี้ส่งผลให้ต้นทุนการดำเนินงานลดลงด้วยแบบจำลองเช่น Deepseek-R1 ซึ่งมีราคาถูกกว่า 96% ในการทำงานมากกว่ารุ่นที่ใหญ่กว่าเช่น O1

อย่างไรก็ตามการเพิ่มประสิทธิภาพเหล่านี้มาพร้อมกับการประนีประนอม โดยทั่วไปแล้วรุ่นที่เล็กกว่าจะได้รับการปรับแต่งสำหรับงานที่เฉพาะเจาะจงซึ่งสามารถจำกัดความเก่งกาจของพวกเขาเมื่อเทียบกับรุ่นที่ใหญ่กว่า ตัวอย่างเช่นในขณะที่ Deepseek-R1 เก่งในวิชาคณิตศาสตร์และการเข้ารหัส แต่ก็ไม่มีความสามารถหลายอย่างเช่นความสามารถในการตีความภาพซึ่งรุ่นที่ใหญ่กว่าเช่น GPT-4O สามารถจัดการได้

แม้จะมีข้อ จำกัด เหล่านี้การใช้งานจริงของแบบจำลองการใช้เหตุผลขนาดเล็กนั้นกว้างขวาง ในการดูแลสุขภาพพวกเขาสามารถใช้พลังงานเครื่องมือวินิจฉัยที่วิเคราะห์ข้อมูลทางการแพทย์บนเซิร์ฟเวอร์โรงพยาบาลมาตรฐาน ในการศึกษาพวกเขาสามารถใช้ในการพัฒนาระบบการสอนส่วนบุคคลให้ข้อเสนอแนะทีละขั้นตอนกับนักเรียน ในการวิจัยทางวิทยาศาสตร์พวกเขาสามารถช่วยในการวิเคราะห์ข้อมูลและการทดสอบสมมติฐานในสาขาเช่นคณิตศาสตร์และฟิสิกส์ ธรรมชาติของโมเดลโอเพ่นซอร์สเช่น Deepseek-R1 ยังส่งเสริมการทำงานร่วมกันและการเข้าถึง AI เป็นประชาธิปไตยทำให้องค์กรขนาดเล็กได้รับประโยชน์จากเทคโนโลยีขั้นสูง

บรรทัดล่าง

วิวัฒนาการของแบบจำลองภาษาเป็นแบบจำลองการให้เหตุผลขนาดเล็กแสดงถึงความก้าวหน้าที่สำคัญใน AI แม้ว่าโมเดลเหล่านี้อาจยังไม่ตรงกับความสามารถในวงกว้างของแบบจำลองภาษาขนาดใหญ่ แต่ก็มีข้อได้เปรียบที่สำคัญในด้านประสิทธิภาพความคุ้มค่าและการเข้าถึง ด้วยการสร้างความสมดุลระหว่างพลังการใช้เหตุผลและประสิทธิภาพของทรัพยากรโมเดลขนาดเล็กจะทรงตัวที่จะมีบทบาทสำคัญในการใช้งานที่หลากหลายทำให้ AI ใช้งานได้จริงและยั่งยืนมากขึ้นสำหรับการใช้ในโลกแห่งความเป็นจริง

-

1

Stardew Valley: คู่มือฉบับสมบูรณ์เกี่ยวกับการเสริมพลังและการตีอาวุธ

Jan 07,2025

-

2

Roblox รหัสจำกัด UGC เปิดตัวในเดือนมกราคม 2025

Jan 06,2025

-

3

Pokémon TCG Pocket: การแก้ไขปัญหาข้อผิดพลาด 102 แก้ไขแล้ว

Jan 08,2025

-

4

Blue Archive เปิดตัวกิจกรรม Cyber New Year มีนาคม

Dec 19,2024

-

5

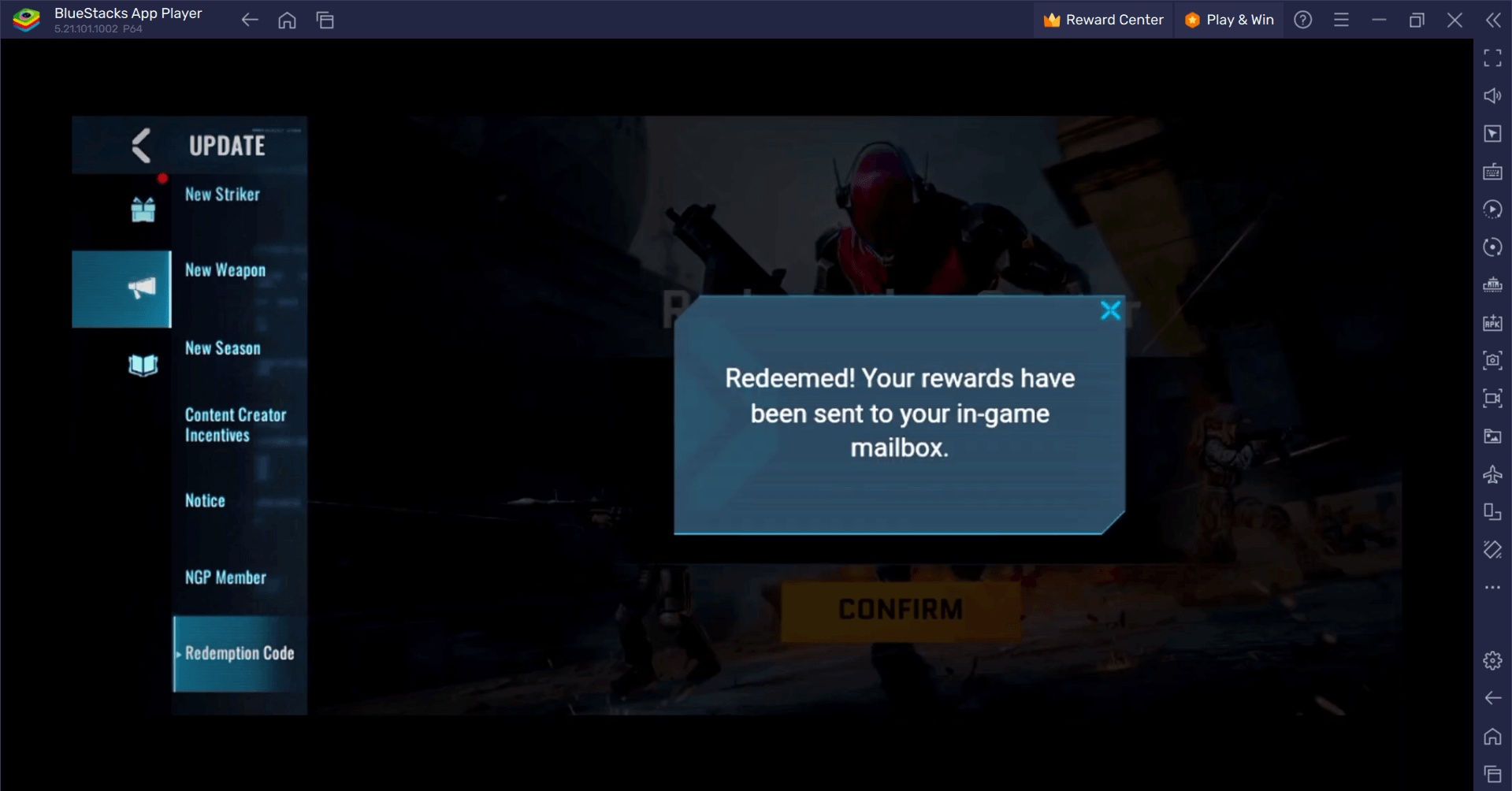

Blood Strike - รหัสแลกใช้งานได้ทั้งหมดมกราคม 2025

Jan 08,2025

-

6

Cyber Quest: มีส่วนร่วมในการต่อสู้ด้วยการ์ดอันน่าหลงใหลบน Android

Dec 19,2024

-

7

![รายการระดับอักขระ Roblox Forsaken [อัปเดต] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

รายการระดับอักขระ Roblox Forsaken [อัปเดต] (2025)

Mar 17,2025

-

8

Bart Bonte ปล่อยปริศนาใหม่ Mister Antonio ที่คุณเล่น Fetch 'For' a Cat!

Dec 18,2024

-

9

Sony เผยโฉมใหม่ Midnight อุปกรณ์เสริม PS5 สีดำ

Jan 08,2025

-

10

Roblox: รหัสคู่แข่ง (มกราคม 2025)

Jan 07,2025

-

ดาวน์โหลด

Random fap scene

ไม่เป็นทางการ / 20.10M

อัปเดต: Dec 26,2024

-

ดาวน์โหลด

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

ไม่เป็นทางการ / 486.00M

อัปเดต: Dec 17,2024

-

ดาวน์โหลด

Arceus X script

การปรับเปลี่ยนในแบบของคุณ / 127.00M

อัปเดต: Oct 21,2021

-

4

A Simple Life with My Unobtrusive Sister

-

5

Ben 10 A day with Gwen

-

6

A Wife And Mother

-

7

Permit Deny

-

8

Oniga Town of the Dead

-

9

Cute Reapers in my Room Android

-

10

Piano White Go! - Piano Games Tiles