Compact AI's redeneerkracht: uitdagende GPT?

In de afgelopen jaren is de AI -gemeenschap gefascineerd door de opmerkelijke prestaties van grote taalmodellen (LLMS). Oorspronkelijk gemaakt voor natuurlijke taalverwerking, zijn deze modellen omgezet in geavanceerde redeneerhulpmiddelen die in staat zijn om ingewikkelde problemen op te lossen met een stapsgewijze denkproces verwant aan menselijke redenering. Ondanks hun geavanceerde mogelijkheden hebben LLMS echter opmerkelijke nadelen, waaronder hoge rekenkosten en langzame implementatiesnelheden, waardoor ze minder haalbaar zijn voor real-world applicaties in resource-beperkte instellingen zoals mobiele apparaten of Edge Computing. Dit heeft een grote interesse gewekt in de ontwikkeling van kleinere, efficiëntere modellen die vergelijkbare redeneermogelijkheden kunnen opleveren en tegelijkertijd de kosten en hulpbronneneisen minimaliseren. Dit artikel duikt in de opkomst van deze kleine redeneermodellen, onderzoekt hun potentieel, uitdagingen en de toekomstige implicaties voor het AI -landschap.

Een verschuiving in perspectief

Voor een belangrijke periode in de recente geschiedenis van AI heeft het veld zich gehouden aan het principe van 'schaalwetten', die stelt dat het modelprestaties voorspelbaar verbetert als gegevens, het berekenen van vermogen en de toename van de modelgrootte. Hoewel deze aanpak inderdaad krachtige modellen heeft opgeleverd, heeft het ook geleid tot aanzienlijke afwegingen, zoals hoge infrastructuurkosten, impact op het milieu en latentiekwesties. Niet alle toepassingen vereisen de volledige mogelijkheden van massale modellen met honderden miljarden parameters. In veel praktische scenario's-zoals on-evice assistenten, gezondheidszorg en onderwijs-kunnen smaller-modellen vergelijkbare resultaten bereiken, op voorwaarde dat ze effectief kunnen redeneren.

Redenering begrijpen in AI

De redenering in AI omvat het vermogen van een model om logische sequenties te volgen, oorzaak en gevolg te begrijpen, implicaties af te leiden, procedurele stappen te plannen en tegenstrijdigheden te identificeren. Voor taalmodellen gaat dit niet alleen om het ophalen van informatie, maar ook het manipuleren en afleiden van gegevens via een gestructureerde, stapsgewijze aanpak. Het bereiken van dit redenering vereist meestal dat we LLM's worden afgestemd om multi-step redenering uit te voeren voordat hij tot een conclusie komt. Hoewel effectief, zijn deze methoden hulpbronnenintensief en kunnen ze traag en duur zijn om te implementeren, waardoor ze bezorgdheid geuit over hun toegankelijkheid en milieu-impact.

Inzicht in kleine redeneermodellen

Kleine redeneermodellen zijn bedoeld om de redeneermogelijkheden van grote modellen te repliceren, maar met een grotere efficiëntie in termen van rekenkracht, geheugengebruik en latentie. Deze modellen maken vaak gebruik van een techniek die bekend staat als kennisdestillatie, waarbij een kleiner model (de "student") leert van een groter, vooraf opgeleid model (de "leraar"). Het destillatieproces omvat het trainen van het kleinere model op gegevens die worden gegenereerd door de grotere, met als doel het redeneervermogen over te dragen. Het studentenmodel wordt vervolgens verfijnd om de prestaties te verbeteren. In sommige gevallen wordt versterking leren met gespecialiseerde domeinspecifieke beloningsfuncties gebruikt om het vermogen van het model om taakspecifieke redenering uit te voeren verder te verfijnen.

De opkomst en vooruitgang van kleine redeneermodellen

Een cruciaal moment in de ontwikkeling van kleine redeneermodellen werd gekenmerkt door de release van Deepseek-R1. Opgeleid op een relatief bescheiden cluster van oudere GPU's, behaalde Deepseek-R1 prestatieniveaus vergelijkbaar met grotere modellen zoals OpenAI's O1 op benchmarks zoals MMLU en GSM-8K. Dit succes heeft geleid tot een herevaluatie van de traditionele schaalbenadering, die ervan uitging dat grotere modellen inherent superieur waren.

Het succes van DeepSeek-R1 kan worden toegeschreven aan het innovatieve trainingsproces, dat grootschalige versterkingsleren combineerde zonder in de vroege stadia te vertrouwen op gecontroleerde verfijningen. Deze innovatie leidde tot het creëren van Deepseek-R1-Zero, een model dat indrukwekkende redeneermogelijkheden toonde in vergelijking met grote redeneermodellen. Verdere verbeteringen, zoals het gebruik van koude startgegevens, verbeterden de coherentie van het model en de uitvoering van het model, met name in gebieden als wiskunde en codering.

Bovendien zijn destillatietechnieken gebleken bij het ontwikkelen van kleinere, efficiëntere modellen van grotere. Deepseek heeft bijvoorbeeld gedistilleerde versies van zijn modellen vrijgegeven, variërend in grootte van 1,5 miljard tot 70 miljard parameters. Met behulp van deze modellen hebben onderzoekers een aanzienlijk kleiner model getraind, Deepseek-R1-Distill-Qwen-32B, dat Openai's O1-Mini over verschillende benchmarks heeft overtroffen. Deze modellen zijn nu inzetbaar op standaardhardware, waardoor ze een meer haalbare optie zijn voor een breed scala aan applicaties.

Kunnen kleine modellen overeenkomen met de redenering op GPT-niveau?

Om te bepalen of kleine redeneermodellen (SRM's) kunnen overeenkomen met de redeneerkracht van grote modellen (LRM's) zoals GPT, is het cruciaal om hun prestaties op standaardbenchmarks te evalueren. Het DeepSeek-R1-model scoorde bijvoorbeeld rond 0,844 op de MMLU-test, vergelijkbaar met grotere modellen zoals O1. Op de GSM-8K-gegevensset, die zich richt op Grade-school wiskunde, behaalde het gedistilleerde model van Deepseek-R1 de topprestaties, die zowel O1 als O1-Mini overtreft.

Bij codeertaken, zoals die op Livecodebench en CodeForces, presteerden de gedistilleerde modellen van Deepseek-R1 op dezelfde manier als O1-Mini en GPT-4O, wat sterke redeneermogelijkheden in programmering aantoont. Grotere modellen hebben echter nog steeds een voordeel in taken die breder taalbegrip vereisen of lange contextvensters hanteren, omdat kleinere modellen meestal meer taakspecifiek zijn.

Ondanks hun sterke punten kunnen kleine modellen worstelen met uitgebreide redeneringstaken of wanneer ze worden geconfronteerd met gegevens buiten de verdeling. In LLM-schaaksimulaties maakte DeepSeek-R1 bijvoorbeeld meer fouten dan grotere modellen, wat duidt op beperkingen in het vermogen om de focus en nauwkeurigheid gedurende langere periodes te behouden.

Afwegingen en praktische implicaties

De afwegingen tussen modelgrootte en prestaties zijn van cruciaal belang bij het vergelijken van SRM's met GPT-niveau LRM's. Kleinere modellen vereisen minder geheugen- en rekenkracht, waardoor ze ideaal zijn voor edge -apparaten, mobiele apps of situaties waar offline conclusie nodig is. Deze efficiëntie resulteert in lagere operationele kosten, waarbij modellen zoals Deepseek-R1 tot 96% goedkoper zijn om te worden uitgevoerd dan grotere modellen zoals O1.

Deze efficiëntiewinsten komen echter met enkele compromissen. Kleinere modellen zijn meestal verfijnd voor specifieke taken, die hun veelzijdigheid kunnen beperken in vergelijking met grotere modellen. Hoewel deepseek-R1 bijvoorbeeld uitblinkt in wiskunde en codering, mist het multimodale mogelijkheden, zoals de mogelijkheid om beelden te interpreteren, die grotere modellen zoals GPT-4O aankan.

Ondanks deze beperkingen zijn de praktische toepassingen van kleine redeneermodellen uitgebreid. In de gezondheidszorg kunnen ze diagnostische hulpmiddelen voeden die medische gegevens analyseren over standaard ziekenhuisservers. In het onderwijs kunnen ze worden gebruikt om gepersonaliseerde tutorsystemen te ontwikkelen en stapsgewijze feedback te geven aan studenten. In wetenschappelijk onderzoek kunnen ze helpen bij gegevensanalyse en hypothesetesten op gebieden zoals wiskunde en natuurkunde. Het open-source karakter van modellen zoals Deepseek-R1 bevordert ook samenwerking en democratiseert de toegang tot AI, waardoor kleinere organisaties kunnen profiteren van geavanceerde technologieën.

De bottom line

De evolutie van taalmodellen in kleinere redeneermodellen is een belangrijke vooruitgang in AI. Hoewel deze modellen mogelijk nog niet volledig overeenkomen met de brede mogelijkheden van grote taalmodellen, bieden ze belangrijke voordelen in efficiëntie, kosteneffectiviteit en toegankelijkheid. Door een evenwicht te vinden tussen redeneerkracht en de efficiëntie van hulpbronnen, zijn kleinere modellen klaar om een cruciale rol te spelen in verschillende toepassingen, waardoor AI praktischer en duurzamer wordt voor gebruik in het praktische.

-

1

Stardew Valley: een complete gids voor betoveringen en het smeden van wapens

Jan 07,2025

-

2

Roblox UGC Limited Codes onthuld voor januari 2025

Jan 06,2025

-

3

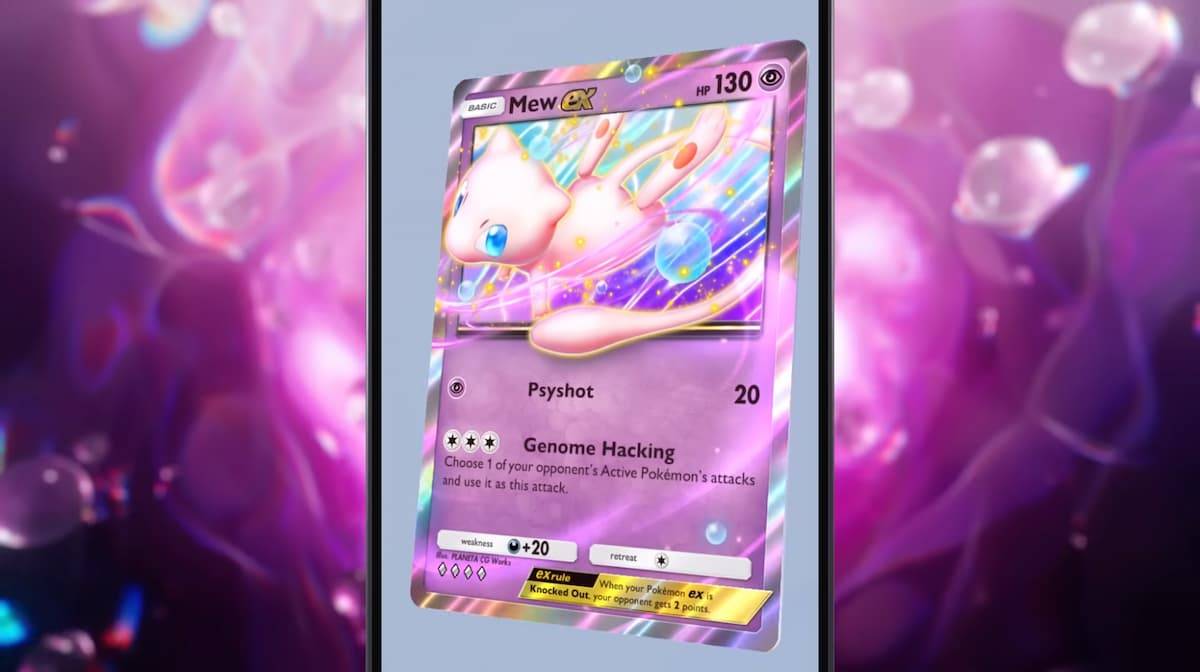

Pokémon TCG Pocket: Probleemoplossing Fout 102 opgelost

Jan 08,2025

-

4

Blue Archive Onthult Cyber Nieuwjaar maart-evenement

Dec 19,2024

-

5

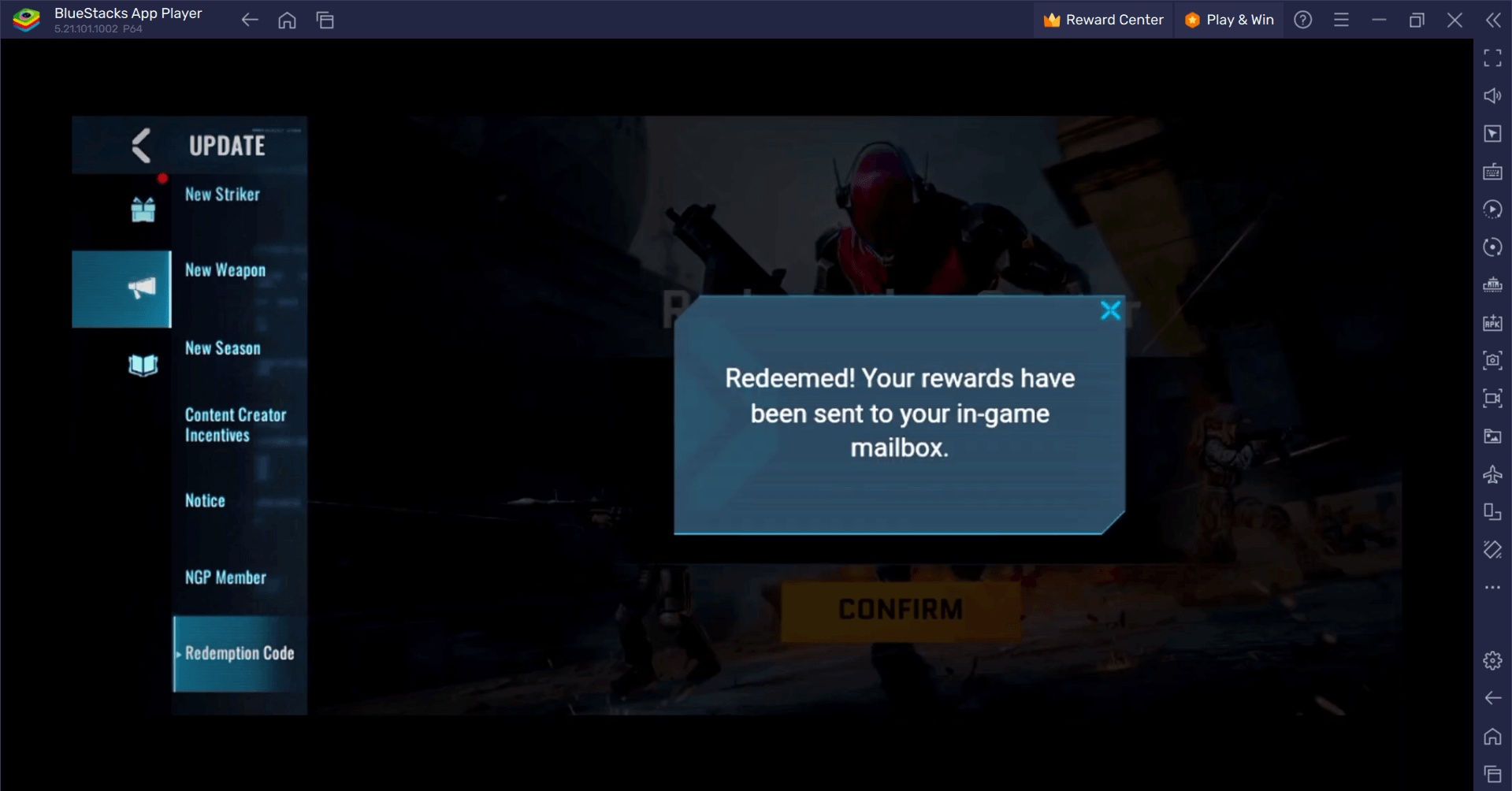

Blood Strike - Alle werkende inwisselcodes januari 2025

Jan 08,2025

-

6

Cyber Quest: neem deel aan boeiende kaartgevechten op Android

Dec 19,2024

-

7

![Roblox Forsaken -tekens Tierlijst [bijgewerkt] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Roblox Forsaken -tekens Tierlijst [bijgewerkt] (2025)

Mar 17,2025

-

8

Bart Bonte laat een nieuwe puzzel vallen, meneer Antonio, waar je speelt Haal 'voor' een kat!

Dec 18,2024

-

9

Sony Onthult nieuwe Midnight zwarte PS5-accessoires

Jan 08,2025

-

10

Roblox: RIVALS-codes (januari 2025)

Jan 07,2025

-

Downloaden

Random fap scene

Casual / 20.10M

Update: Dec 26,2024

-

Downloaden

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

Casual / 486.00M

Update: Dec 17,2024

-

Downloaden

Arceus X script

Personalisatie / 127.00M

Update: Oct 21,2021

-

4

A Simple Life with My Unobtrusive Sister

-

5

Ben 10 A day with Gwen

-

6

A Wife And Mother

-

7

Permit Deny

-

8

Oniga Town of the Dead

-

9

Cute Reapers in my Room Android

-

10

Piano White Go! - Piano Games Tiles