紧凑型AI的推理能力:挑战GPT?

近年来,AI社区对大语言模型(LLM)的非凡成就着迷。这些模型最初是针对自然语言处理的,已转变为复杂的推理工具,能够通过类似于人类推理的逐步思考过程来解决复杂的问题。但是,尽管具有高级功能,但LLMS仍具有显着的缺点,包括高计算成本和缓慢的部署速度,这使得它们对于资源有限设置(例如移动设备或Edge Computing)中现实世界应用程序的可行性降低了。这引起了人们对开发较小,更高效的模型的浓厚兴趣,这些模型可以提供可比的推理能力,同时最大程度地减少成本和资源需求。本文深入研究了这些小推理模型的出现,探讨了它们对AI景观的潜力,挑战和未来的影响。

观点的转变

在最近的AI历史上,该领域遵守“缩放定律”的原则,该原则认为,随着数据,计算功率和模型大小的增加,模型性能可以预见。尽管这种方法确实产生了强大的模型,但它也导致了相当大的权衡,例如高基础设施成本,环境影响和延迟问题。并非所有应用都需要具有数百亿个参数的大型模型的全部功能。在许多实际情况下,例如在设备助理,医疗保健和教育等方面,如果他们可以有效地推理,那么笨拙的模型就可以实现可比的结果。

了解AI中的推理

AI中的推理涵盖了模型遵循逻辑序列,理解因果关系,推论含义,计划程序步骤并确定矛盾的能力。对于语言模型,这不仅涉及检索信息,还涉及通过结构化的逐步方法来操纵和推断数据。达到这种推理水平通常需要微调LLM在得出结论之前执行多步推理。尽管有效,但这些方法是资源密集的,部署可能会缓慢且昂贵,从而引起人们对它们的可及性和环境影响的担忧。

了解小推理模型

小推理模型旨在复制大型模型的推理能力,但在计算能力,内存使用和延迟方面具有更高的效率。这些模型经常利用一种称为知识蒸馏的技术,其中较小的模型(“学生”)从较大的预训练模型(“老师”)中学习。蒸馏过程涉及对较大数据生成的数据培训较小的模型,旨在转移推理能力。然后,对学生模型进行微调以提高其性能。在某些情况下,采用特定领域特定奖励功能的强化学习来进一步完善模型执行特定于任务推理的能力。

小推理模型的兴起和进步

DeepSeek-R1的释放标志着小型推理模型的发展中的关键时刻。 DeepSeek-R1接受了相对较旧的GPU群的培训,其性能水平与较大模型(如MMLU和GSM-8K)上的OpenAI的O1(例如Openai的O1)相当。这种成功促使对传统缩放方法进行了重新评估,该方法假设较大的模型本质上是优越的。

DeepSeek-R1的成功可以归因于其创新的培训过程,该过程将大规模的强化学习结合在一起,而无需在早期阶段依靠监督的微调。这项创新导致了DeepSeek-R1-Zero的创建,该模型与大型推理模型相比展示了令人印象深刻的推理能力。进一步的增强功能,例如使用冷启动数据,改善了模型的连贯性和任务执行,尤其是在数学和编码等领域。

此外,蒸馏技术已证明有助于从较大的模型开发较小,更有效的模型。例如,DeepSeek发布了其型号的蒸馏版本,规模从15亿到700亿参数不等。使用这些模型,研究人员培训了一个明显较小的模型,DeepSeek-R1-Distill-Qwen-32b,该模型在各种基准测试中的表现优于OpenAI的O1-Mini。这些模型现在可以在标准硬件上部署,使其成为广泛应用程序的更可行的选择。

小型型号可以匹配GPT级别的推理吗?

为了确定小型推理模型(SRMS)是否可以匹配大型模型(LRM)(例如GPT)的推理能力,评估其在标准基准测试上的性能至关重要。例如,在MMLU测试中,DeepSeek-R1模型在0.844左右得分,与大型模型(例如O1)相当。 DeepSeek-R1的蒸馏型在GSM-8K数据集(GSM-8K数据集)上,达到了顶级性能,超过了O1和O1 Mini。

在编码任务(例如LiveCodeBench和CodeForces上的任务)中,DeepSeek-R1的蒸馏模型的执行方式类似于O1-Mini和GPT-4O,在编程中表明了强大的推理能力。但是,较大的模型仍然具有需要更广泛的语言理解或处理长上下文窗口的任务,因为较小的模型往往更为特定。

尽管有优势,但小型模型仍可能在扩展的推理任务或面对分发数据时挣扎。例如,在LLM国际象棋模拟中,DeepSeek-R1比大型模型犯了更多的错误,这表明其在长时间保持专注和准确性的能力限制。

权衡和实践意义

将SRM与GPT级LRMS进行比较时,模型大小和性能之间的权衡至关重要。较小的模型需要更少的内存和计算能力,使其非常适合边缘设备,移动应用程序或需要离线推理的情况。这种效率会导致运营成本较低,而诸如DeepSeek-R1之类的型号比O1等大型型号便宜96%。

但是,这些效率提高带来了一些妥协。较小的模型通常用于特定任务,与较大的型号相比,这可能会限制其多功能性。例如,尽管DeepSeek-R1在数学和编码方面表现出色,但它缺乏多模式功能,例如解释图像的能力,例如GPT-4O(例如GPT-4O)可以处理的图像。

尽管存在这些限制,但小推理模型的实际应用是广泛的。在医疗保健方面,它们可以为分析标准医院服务器的医疗数据提供动力。在教育方面,它们可用于开发个性化的辅导系统,向学生提供逐步的反馈。在科学研究中,他们可以在数学和物理等领域进行数据分析和假设检验。诸如DeepSeek-R1之类的模型的开源性质也促进了协作并使对AI的访问权限,使较小的组织能够从先进的技术中受益。

底线

语言模型中较小的推理模型的演变代表了AI的重大进步。尽管这些模型可能尚未完全匹配大语言模型的广泛功能,但它们在效率,成本效益和可访问性方面具有关键优势。通过在推理能力和资源效率之间达到平衡,较小的模型有望在各种应用程序中发挥关键作用,从而使AI更实用和可持续,可用于现实世界中。

-

Here Comes Impregno Man! Next Target is an American Wife

-

Prado Car Parking Game 2023

-

Scary Mansion:逃脱恐怖的邻居杀手,生存杀人游戏

-

Fabulous Las Vegas Mystery – Free Hidden Objects

-

Subway Icy Princess Rush Mod

-

HungryAliens

-

Chess Collection 2018

-

Harem

-

Bouncing Boobs Club

-

Diamond Lotto

-

Narde - Backgammon Free

-

Snakes And Ladders Star:2019 New Dice Game

-

1

](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Roblox Forsaken字符层列表[更新](2025)

Mar 17,2025

-

2

Roblox 2025 年 1 月公布的 UGC 限量代码

Jan 06,2025

-

3

Stardew Valley:附魔和武器锻造的完整指南

Jan 07,2025

-

4

Pokémon TCG Pocket:故障排除错误 102 已解决

Jan 08,2025

-

5

免费火角色2025:终极指南

Feb 20,2025

-

6

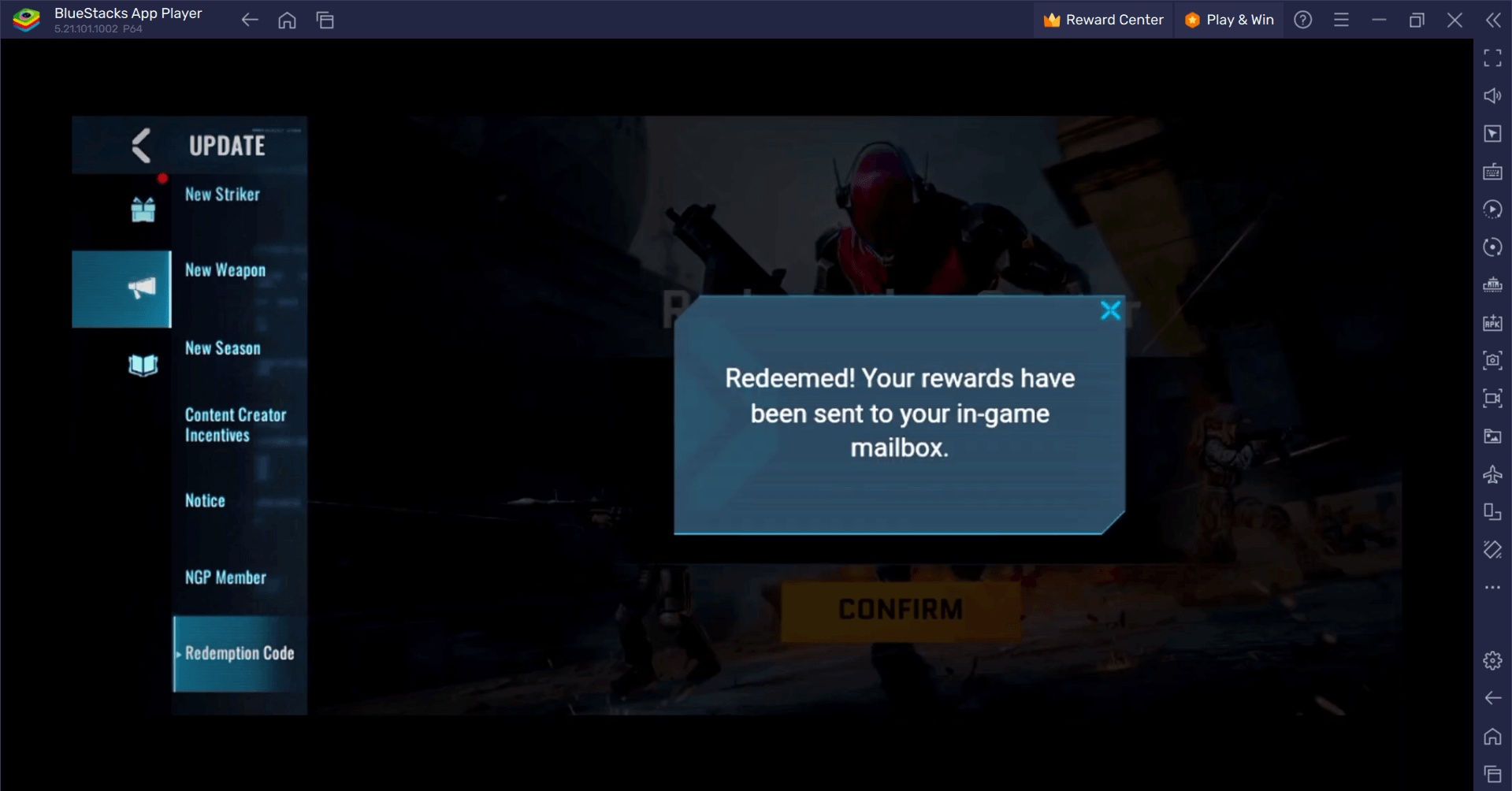

Blood Strike - 所有可用的兑换代码 2025 年 1 月

Jan 08,2025

-

7

Blue Archive 推出网络新年三月活动

Dec 19,2024

-

8

Roblox:RIVALS 代码(2025 年 1 月)

Jan 07,2025

-

9

Cyber Quest:在 Android 上参与引人入胜的卡牌战斗

Dec 19,2024

-

10

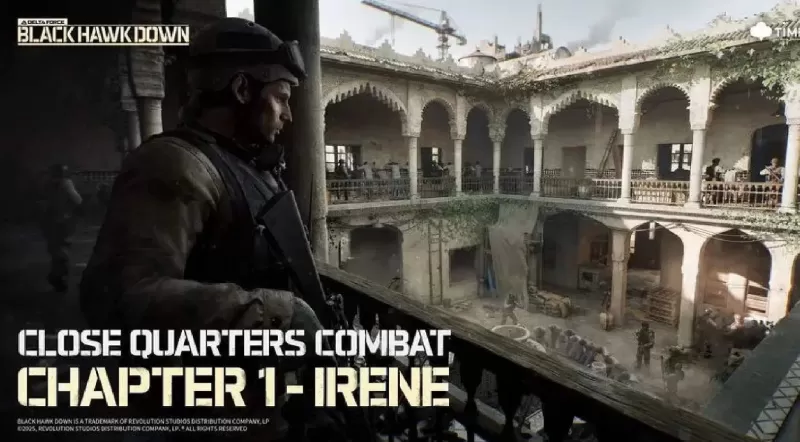

三角洲力量:所有竞选任务的完整指南

Apr 09,2025

-

下载

A Simple Life with My Unobtrusive Sister

休闲 / 392.30M

更新日期: Mar 27,2025

-

下载

Random fap scene

休闲 / 20.10M

更新日期: Dec 26,2024

-

下载

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

休闲 / 486.00M

更新日期: Dec 17,2024

-

4

Ben 10 A day with Gwen

-

5

Oniga Town of the Dead

-

6

A Wife And Mother

-

7

Cute Reapers in my Room Android

-

8

Permit Deny

-

9

Utouto Suyasuya

-

10

Roblox