El poder de razonamiento de la IA compacta: ¿Desafiando a GPT?

En los últimos años, la comunidad de IA ha sido fascinada por los notables logros de los modelos de idiomas grandes (LLM). Originalmente elaborado para el procesamiento del lenguaje natural, estos modelos se han transformado en sofisticadas herramientas de razonamiento capaces de resolver problemas intrincados con un proceso de pensamiento paso a paso similar al razonamiento humano. Sin embargo, a pesar de sus capacidades avanzadas, los LLM tienen inconvenientes notables, incluidos los altos costos computacionales y las velocidades de implementación lentas, lo que los hace menos factibles para aplicaciones del mundo real en configuraciones limitadas por recursos, como dispositivos móviles o informática de borde. Esto ha provocado un gran interés en el desarrollo de modelos más pequeños y más eficientes que pueden ofrecer habilidades de razonamiento comparables al tiempo que minimiza los costos y las demandas de recursos. Este artículo profundiza en la aparición de estos pequeños modelos de razonamiento, explorando su potencial, desafíos y las futuras implicaciones para el panorama de la IA.

Un cambio en la perspectiva

Durante un período significativo en la historia reciente de la IA, el campo se ha adherido al principio de las "leyes de escala", que postula que el rendimiento del modelo mejora predecible como datos, potencia de cálculo y aumento del tamaño del modelo. Si bien este enfoque ha producido modelos poderosos, también ha llevado a compensaciones considerables, como altos costos de infraestructura, impacto ambiental y problemas de latencia. No todas las aplicaciones requieren las capacidades completas de los modelos masivos con cientos de miles de millones de parámetros. En muchos escenarios prácticos, como los asistentes en el dispositivo, la salud y la educación, los modelos más pequeños pueden lograr resultados comparables, siempre que puedan razonar de manera efectiva.

Comprender el razonamiento en la IA

El razonamiento en AI abarca la capacidad de un modelo para seguir secuencias lógicas, comprender la causa y el efecto, deducir implicaciones, planificar pasos de procedimiento e identificar contradicciones. Para los modelos de lenguaje, esto implica no solo recuperar información sino también manipular e inferir datos a través de un enfoque estructurado y paso a paso. Lograr este nivel de razonamiento generalmente requiere un ajuste de LLM para realizar un razonamiento de varios pasos antes de llegar a una conclusión. Si bien son efectivos, estos métodos son intensivos en recursos y pueden ser lentos y costosos de desplegar, lo que plantea preocupaciones sobre su accesibilidad e impacto ambiental.

Comprender los pequeños modelos de razonamiento

Los pequeños modelos de razonamiento tienen como objetivo replicar las capacidades de razonamiento de modelos grandes pero con una mayor eficiencia en términos de potencia computacional, uso de memoria y latencia. Estos modelos a menudo utilizan una técnica conocida como destilación de conocimiento, donde un modelo más pequeño (el "estudiante") aprende de un modelo más grande y previamente capacitado (el "maestro"). El proceso de destilación implica capacitar el modelo más pequeño en los datos generados por el más grande, con el objetivo de transferir la capacidad de razonamiento. El modelo de estudiante se ajusta para mejorar su rendimiento. En algunos casos, el aprendizaje de refuerzo con funciones especializadas de recompensa de dominio se emplea para refinar aún más la capacidad del modelo para realizar un razonamiento específico de tareas.

El aumento y los avances de los pequeños modelos de razonamiento

Un momento fundamental en el desarrollo de pequeños modelos de razonamiento estuvo marcado por el lanzamiento de Deepseek-R1. Entrenado en un clúster relativamente modesto de GPU más antiguas, Deepseek-R1 logró niveles de rendimiento comparables a modelos más grandes como Openi's O1 en puntos de referencia como MMLU y GSM-8K. Este éxito ha provocado una reevaluación del enfoque de escala tradicional, que asumió que los modelos más grandes eran inherentemente superiores.

El éxito de Deepseek-R1 puede atribuirse a su innovador proceso de capacitación, que combinó el aprendizaje de refuerzo a gran escala sin depender del ajuste superior supervisado en las primeras etapas. Esta innovación condujo a la creación de Deepseek-R1-Zero, un modelo que muestra impresionantes capacidades de razonamiento en comparación con los grandes modelos de razonamiento. Otras mejoras, como el uso de datos de arranque en frío, mejoraron la coherencia y la ejecución de tareas del modelo, particularmente en áreas como las matemáticas y la codificación.

Además, las técnicas de destilación han demostrado ser fundamentales para desarrollar modelos más pequeños y más eficientes de los más grandes. Por ejemplo, Deepseek ha lanzado versiones destiladas de sus modelos, que van en tamaño de 1.500 millones a 70 mil millones de parámetros. Utilizando estos modelos, los investigadores han entrenado un modelo significativamente más pequeño, Deepseek-R1-Distill-Qwen-32b, que ha superado a OpenAi's O1-Mini en varios puntos de referencia. Estos modelos ahora se pueden implementar en hardware estándar, lo que los convierte en una opción más viable para una amplia gama de aplicaciones.

¿Pueden los modelos pequeños coincidir con el razonamiento de nivel GPT?

Para determinar si los modelos de razonamiento pequeños (SRMS) pueden igualar el poder de razonamiento de los modelos grandes (LRM) como GPT, es crucial evaluar su rendimiento en puntos de referencia estándar. Por ejemplo, el modelo Deepseek-R1 obtuvo alrededor de 0.844 en la prueba MMLU, comparable a modelos más grandes como O1. En el conjunto de datos GSM-8K, que se centra en las matemáticas de la escuela primaria, el modelo destilado de Deepseek-R1 alcanzó el rendimiento de primer nivel, superando los O1 y O1-Mini.

En tareas de codificación, como las de LivecodeBench y CodeForces, los modelos destilados de Deepseek-R1 se desempeñaron de manera similar a O1-Mini y GPT-4O, lo que demuestra fuertes capacidades de razonamiento en la programación. Sin embargo, los modelos más grandes aún tienen una ventaja en las tareas que requieren una comprensión de lenguaje más amplia o manejar ventanas de contexto largas, ya que los modelos más pequeños tienden a ser más específicos de la tarea.

A pesar de sus fortalezas, los modelos pequeños pueden luchar con tareas de razonamiento extendidas o cuando se enfrentan a datos fuera de distribución. Por ejemplo, en las simulaciones de ajedrez LLM, Deepseek-R1 cometió más errores que los modelos más grandes, lo que indica limitaciones en su capacidad para mantener el enfoque y la precisión durante períodos prolongados.

Compensaciones e implicaciones prácticas

Las compensaciones entre el tamaño del modelo y el rendimiento son críticas cuando se comparan SRMS con LRM de nivel GPT. Los modelos más pequeños requieren menos memoria y potencia computacional, lo que los hace ideales para dispositivos de borde, aplicaciones móviles o situaciones donde es necesaria la inferencia fuera de línea. Esta eficiencia da como resultado costos operativos más bajos, con modelos como Deepseek-R1 de hasta un 96% más barato para funcionar que los modelos más grandes como O1.

Sin embargo, estas ganancias de eficiencia vienen con algunos compromisos. Los modelos más pequeños generalmente se ajustan para tareas específicas, lo que puede limitar su versatilidad en comparación con los modelos más grandes. Por ejemplo, mientras Deepseek-R1 sobresale en matemáticas y codificación, carece de capacidades multimodales, como la capacidad de interpretar imágenes, que modelos más grandes como GPT-4O pueden manejar.

A pesar de estas limitaciones, las aplicaciones prácticas de los pequeños modelos de razonamiento son extensas. En la atención médica, pueden alimentar herramientas de diagnóstico que analizan datos médicos en servidores de hospital estándar. En educación, se pueden utilizar para desarrollar sistemas de tutoría personalizados, proporcionando comentarios paso a paso a los estudiantes. En la investigación científica, pueden ayudar con el análisis de datos y las pruebas de hipótesis en campos como las matemáticas y la física. La naturaleza de código abierto de modelos como Deepseek-R1 también fomenta la colaboración y democratiza el acceso a la IA, lo que permite a las organizaciones más pequeñas beneficiarse de las tecnologías avanzadas.

El resultado final

La evolución de los modelos de lenguaje en modelos de razonamiento más pequeños representa un avance significativo en la IA. Si bien estos modelos aún no coinciden completamente con las capacidades amplias de los modelos de idiomas grandes, ofrecen ventajas clave en la eficiencia, la rentabilidad y la accesibilidad. Al lograr un equilibrio entre el poder de razonamiento y la eficiencia de los recursos, los modelos más pequeños están listos para desempeñar un papel crucial en varias aplicaciones, lo que hace que la IA sea más práctica y sostenible para el uso del mundo real.

-

Here Comes Impregno Man! Next Target is an American Wife

-

Prado Car Parking Game 2023

-

Scary Mansion:Escape de Terror

-

Fabulous Las Vegas Mystery – Free Hidden Objects

-

Subway Icy Princess Rush Mod

-

HungryAliens

-

Chess Collection 2018

-

Harem

-

Bouncing Boobs Club

-

Diamond Lotto

-

Narde - Backgammon Free

-

Snakes And Ladders Star:2019 New Dice Game

-

1

![Lista de nivel de caracteres abandonado de Roblox [Actualizado] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Lista de nivel de caracteres abandonado de Roblox [Actualizado] (2025)

Mar 17,2025

-

2

Roblox Códigos UGC limitados revelados para enero de 2025

Jan 06,2025

-

3

Stardew Valley: Una guía completa de encantamientos y forja de armas

Jan 07,2025

-

4

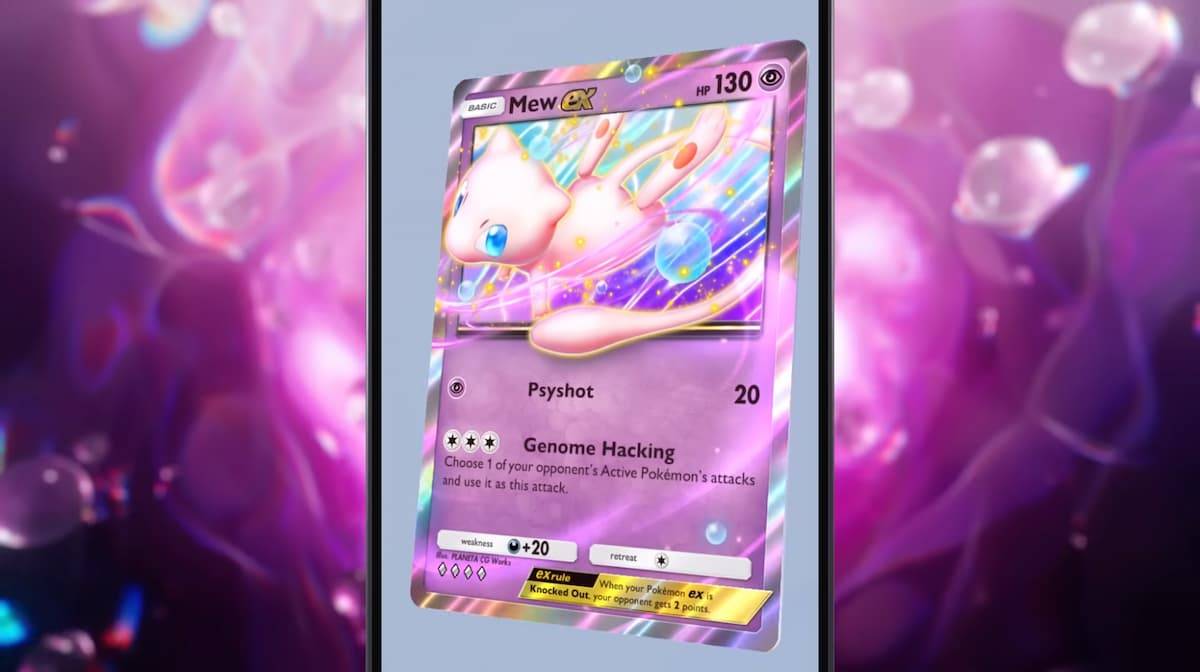

Pokémon TCG Pocket: Solución de problemas Error 102 resuelto

Jan 08,2025

-

5

Personajes de Free Fire 2025: Ultimate Guide

Feb 20,2025

-

6

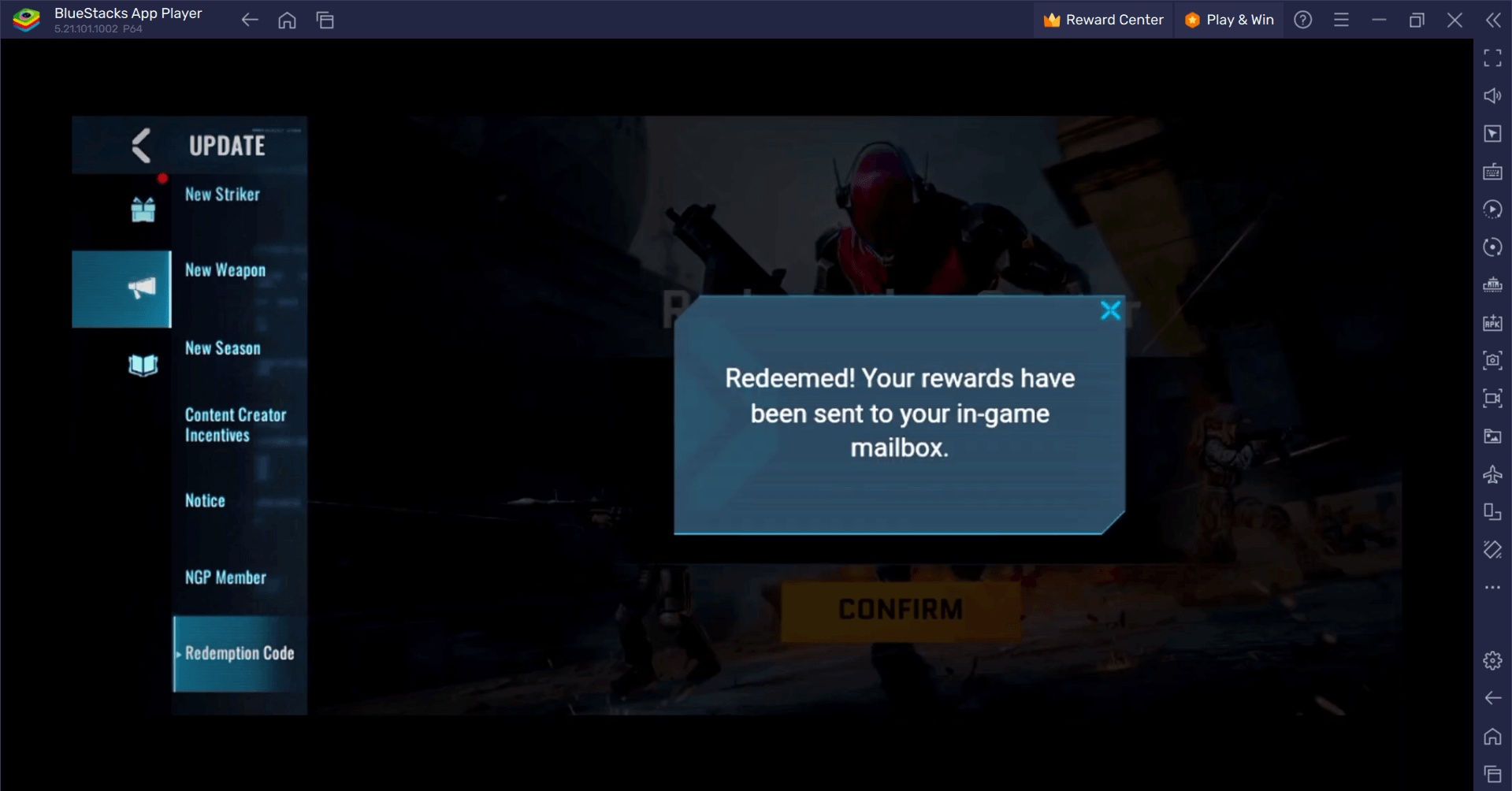

Blood Strike: todos los códigos de canje que funcionan en enero de 2025

Jan 08,2025

-

7

Blue Archive Presenta el evento cibernético de marzo de Año Nuevo

Dec 19,2024

-

8

Roblox: Códigos RIVALS (enero 2025)

Jan 07,2025

-

9

Cyber Quest: participa en cautivadoras batallas de cartas en Android

Dec 19,2024

-

10

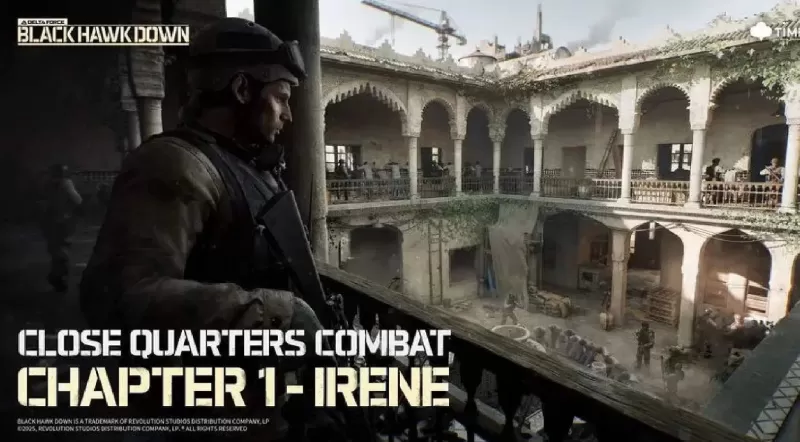

Delta Force: una guía completa para todas las misiones de campaña

Apr 09,2025

-

Descargar

A Simple Life with My Unobtrusive Sister

Casual / 392.30M

Actualizar: Mar 27,2025

-

Descargar

Random fap scene

Casual / 20.10M

Actualizar: Dec 26,2024

-

Descargar

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

Casual / 486.00M

Actualizar: Dec 17,2024

-

4

Ben 10 A day with Gwen

-

5

Oniga Town of the Dead

-

6

A Wife And Mother

-

7

Cute Reapers in my Room Android

-

8

Permit Deny

-

9

Utouto Suyasuya

-

10

Roblox