Компактная сила ИИ: бросает вызов GPT?

В последние годы сообщество ИИ было очаровано замечательными достижениями крупных языковых моделей (LLMS). Первоначально созданные для обработки естественного языка, эти модели превратились в сложные инструменты рассуждения, способные решать сложные проблемы с пошаговым процессом мышления, сродни человеческим рассуждениям. Однако, несмотря на их расширенные возможности, LLM имеют заметные недостатки, в том числе высокие вычислительные затраты и медленные скорости развертывания, что делает их менее возможными для реальных приложений в настройках с ограниченными ресурсами, такими как мобильные устройства или краевые вычисления. Это вызвало большой интерес к разработке более мелких и более эффективных моделей, которые могут обеспечить сопоставимые способности рассуждения, при этом минимизировать затраты и потребности в ресурсах. Эта статья углубляется в появление этих небольших моделей рассуждений, исследуя их потенциал, проблемы и будущие последствия для ландшафта ИИ.

Сдвиг в перспективе

В течение значительного периода в недавней истории ИИ область придерживалась принципа «законов масштабирования», который утверждает, что производительность модели улучшается в предсказуемо, поскольку данные, вычисление мощности и увеличение размера модели. Хотя этот подход действительно создал мощные модели, он также привел к значительным компромиссам, таким как высокие затраты на инфраструктуру, воздействие на окружающую среду и проблемы с задержкой. Не все приложения требуют полных возможностей массовых моделей с сотнями миллиардов параметров. Во многих практических сценариях, таких как ассистенты на поступлении, здравоохранение и образование, модели, модели, могут достичь сопоставимых результатов, при условии, что они могут эффективно рассуждать.

Понимание рассуждений в ИИ

Рассуждение в ИИ охватывает способность модели следовать логическим последовательностям, понимать причину и следствие, вывести последствия, процедурные шаги планирования и выявлять противоречия. Для языковых моделей это включает не только получение информации, но и манипулирование и вывод данных с помощью структурированного пошагового подхода. Достижение этого уровня рассуждений, как правило, требует тонкой настройки LLM для выполнения многоэтапных рассуждений, прежде чем прийти к выводу. Несмотря на эффективные, эти методы являются ресурсными и могут быть медленными и дорогостоящими для развертывания, что вызывает опасения по поводу их доступности и воздействия на окружающую среду.

Понимание небольших моделей рассуждений

Небольшие модели рассуждений направлены на то, чтобы воспроизвести возможности рассуждений крупных моделей, но с большей эффективностью с точки зрения вычислительной мощности, использования памяти и задержки. Эти модели часто используют технику, известную как дистилляция знаний, где меньшая модель («ученик») учится на более крупной, предварительно обученной модели («учитель»). Процесс дистилляции включает в себя обучение меньшей модели данных, генерируемым более крупной, направленной на передачу способности рассуждения. Студенческая модель затем настраивается, чтобы повысить свою производительность. В некоторых случаях обучение подкреплению со специализированными функциями вознаграждения, специфичных для домена, используется для дальнейшего уточнения способности модели выполнять специфические для задачи рассуждения.

Рост и достижения малых моделей рассуждений

Ключевой момент в разработке небольших моделей рассуждений был отмечен выпуском DeepSeek-R1. Обученный на относительно скромном кластере более старых графических процессоров, DeepSeek-R1 достиг уровней производительности, сравнимых с более крупными моделями, такими как O1 Openai, на контрольных показателях, таких как MMLU и GSM-8K. Этот успех вызвал переоценку традиционного подхода к масштабированию, который предполагал, что более крупные модели были по своей природе превосходными.

Успех DeepSeek-R1 может быть связан с его инновационным процессом обучения, который сочетал в комбинации крупномасштабного обучения подкреплению, не полагаясь на контролируемую тонкую настройку на ранних стадиях. Это инновация привела к созданию DeepSeek-R1-Zero, модели, которая продемонстрировала впечатляющие возможности рассуждения по сравнению с большими моделями рассуждений. Дальнейшие улучшения, такие как использование данных о холодном начале, улучшили когерентность и выполнение задач модели, особенно в таких областях, как математика и кодирование.

Кроме того, методы дистилляции оказались инструментальными в разработке более мелких и более эффективных моделей из более крупных. Например, DeepSeek выпустила дистиллированные версии своих моделей, размером от 1,5 до 70 миллиардов параметров. Используя эти модели, исследователи обучили значительно меньшую модель, DeepSeek-R1-Distill-QWEN-32B, которая превзошла O1-Mini OpenAI по различным критериям. Эти модели в настоящее время развернуты на стандартном оборудовании, что делает их более жизнеспособным вариантом для широкого спектра приложений.

Могут ли небольшие модели соответствовать рассуждениям на уровне GPT?

Чтобы определить, могут ли небольшие модели рассуждений (SRM) соответствовать мощности рассуждений крупных моделей (LRM), таких как GPT, важно оценить их производительность по стандартным критериям. Например, модель DeepSeek-R1 набрала около 0,844 на тесте MMLU, сравнимой с более крупными моделями, такими как O1. На наборе данных GSM-8K, который фокусируется на математике школы класса, дистиллированная модель DeepSeek-R1 достигла производительности высшего уровня, превысив как O1, так и O1-Mini.

В задачах кодирования, таких как задачи на LiveCodebench и Codeforces, дистиллированные модели DeepSeek-R1 выполняли аналогично O1-Mini и GPT-4O, демонстрируя сильные возможности рассуждения в программировании. Тем не менее, более крупные модели по-прежнему имеют преимущество в задачах, требующих более широкого понимания языка или обработки длинных контекстных окон, поскольку более мелкие модели, как правило, более специфичны для задач.

Несмотря на их сильные стороны, небольшие модели могут бороться с расширенными задачами рассуждений или при столкновении с данными за пределами распределения. Например, при шахматном моделировании LLM DeepSeek-R1 совершал больше ошибок, чем более крупные модели, что указывает на ограничения в его способности поддерживать фокус и точность в течение длительных периодов.

Компромиссы и практические последствия

Компромисс между размером модели и производительностью имеют решающее значение при сравнении SRM с LRM на уровне GPT. Меньшие модели требуют меньше памяти и вычислительной мощности, что делает их идеальными для устройств, мобильных приложений или ситуаций, где необходим автономный вывод. Эта эффективность приводит к более низким эксплуатационным затратам, при этом модели, такие как DeepSeek-R1, на 96% дешевле, чем более крупные модели, такие как O1.

Тем не менее, эти повышения эффективности поставляются с некоторыми компромиссами. Меньшие модели, как правило, настраиваются на определенные задачи, которые могут ограничить их универсальность по сравнению с более крупными моделями. Например, в то время как DeepSeek-R1 превосходит по математике и кодированию, ему не хватает мультимодальных возможностей, таких как способность интерпретировать изображения, с которыми могут обращаться более крупные модели, такие как GPT-4O.

Несмотря на эти ограничения, практическое применение малых моделей рассуждений обширно. В здравоохранении они могут питать диагностические инструменты, которые анализируют медицинские данные на стандартных больничных серверах. В образовании их можно использовать для разработки персонализированных систем обучения, обеспечивая пошаговую обратную связь для студентов. В научных исследованиях они могут помочь с анализом данных и тестированием гипотез в таких областях, как математика и физика. Характер с открытым исходным кодом, таких как DeepSeek-R1, также способствует сотрудничеству и демократизирует доступ к ИИ, что позволяет небольшим организациям извлечь выгоду из передовых технологий.

Суть

Эволюция языковых моделей в более мелкие модели рассуждений представляет собой значительный прогресс в ИИ. Хотя эти модели еще не могут полностью соответствовать широким возможностям крупных языковых моделей, они предлагают ключевые преимущества в эффективности, экономической эффективности и доступности. Выразив баланс между рассуждением силой и эффективностью ресурсов, более мелкие модели готовы играть решающую роль в различных приложениях, что делает ИИ более практичным и устойчивым для реального использования.

-

Here Comes Impregno Man! Next Target is an American Wife

-

Prado Car Parking Game 2023

-

Scary Mansion:Страшная игра 3D

-

Fabulous Las Vegas Mystery – Free Hidden Objects

-

Subway Icy Princess Rush Mod

-

HungryAliens

-

Chess Collection 2018

-

Harem

-

Bouncing Boobs Club

-

Diamond Lotto

-

Narde - Backgammon Free

-

Snakes And Ladders Star:2019 New Dice Game

-

1

![Roblox Forsakencess Screces Lier Lier [Обновлено] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Roblox Forsakencess Screces Lier Lier [Обновлено] (2025)

Mar 17,2025

-

2

Roblox Ограниченные коды пользовательского контента представлены в январе 2025 года

Jan 06,2025

-

3

Stardew Valley: Полное руководство по зачарованию и ковке оружия

Jan 07,2025

-

4

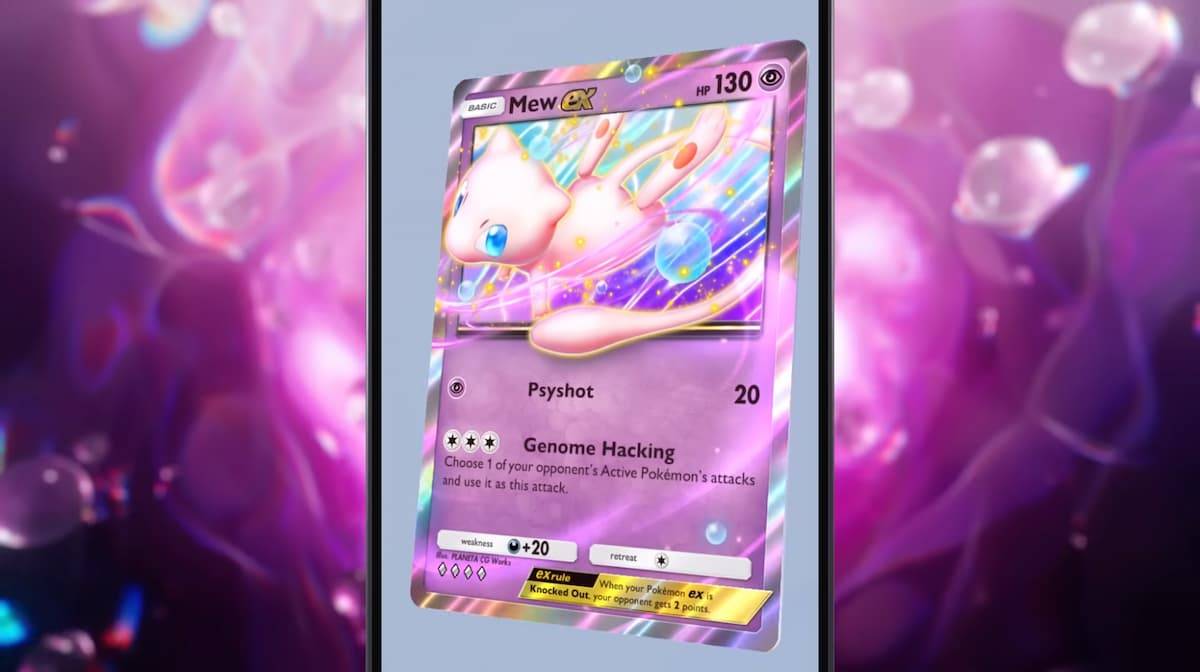

Pokémon TCG Pocket: устранение ошибки 102

Jan 08,2025

-

5

Бесплатный пожарный персонажи 2025: Ultimate Guide

Feb 20,2025

-

6

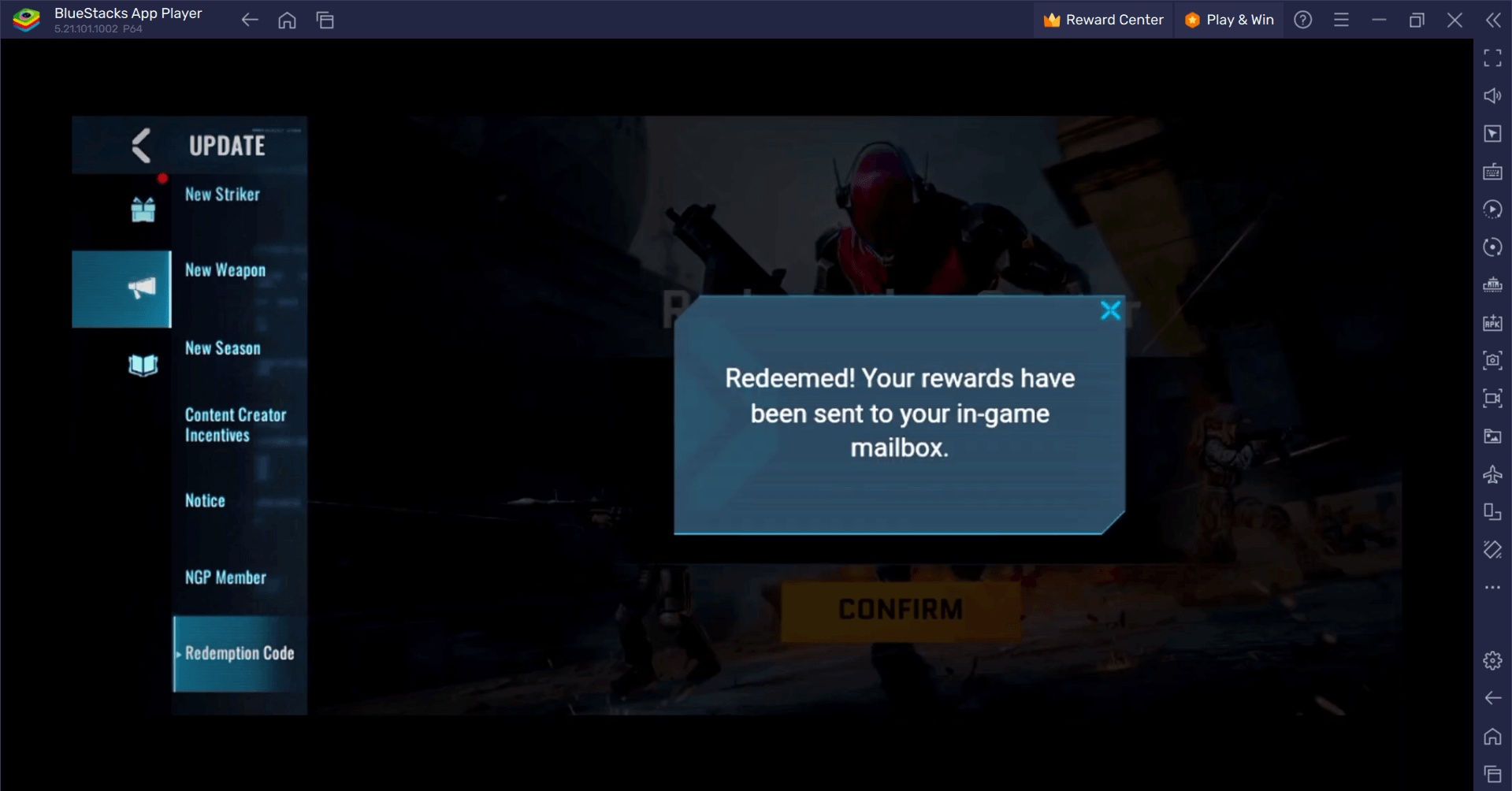

Blood Strike — все рабочие коды активации, январь 2025 г.

Jan 08,2025

-

7

Blue Archive Представляет мартовское киберновогоднее мероприятие

Dec 19,2024

-

8

Roblox: Коды RIVALS (январь 2025 г.)

Jan 07,2025

-

9

Cyber Quest: участвуйте в захватывающих карточных битвах на Android

Dec 19,2024

-

10

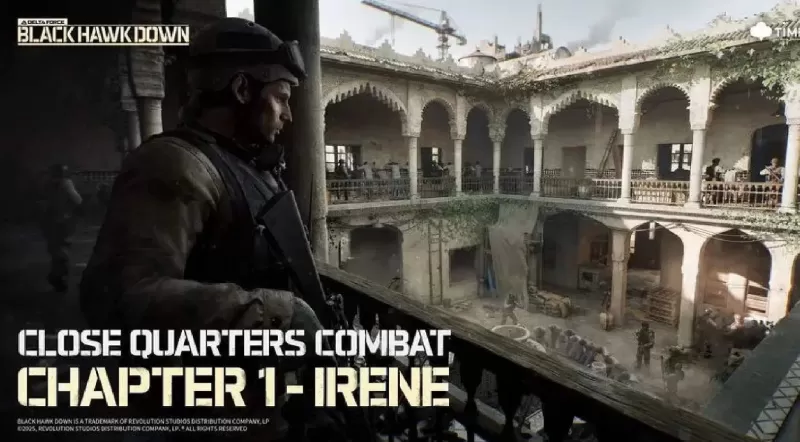

Delta Force: Полное руководство по всем миссиям кампании

Apr 09,2025

-

Скачать

A Simple Life with My Unobtrusive Sister

Повседневный / 392.30M

Обновлять: Mar 27,2025

-

Скачать

Random fap scene

Повседневный / 20.10M

Обновлять: Dec 26,2024

-

Скачать

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

Повседневный / 486.00M

Обновлять: Dec 17,2024

-

4

Ben 10 A day with Gwen

-

5

Oniga Town of the Dead

-

6

A Wife And Mother

-

7

Cute Reapers in my Room Android

-

8

Permit Deny

-

9

Utouto Suyasuya

-

10

Roblox