Poder de raciocínio compacto da IA: desafiando o GPT?

Nos últimos anos, a comunidade de IA foi fascinada pelas notáveis realizações de grandes modelos de idiomas (LLMS). Originalmente criado para o processamento de linguagem natural, esses modelos se transformaram em ferramentas sofisticadas de raciocínio capazes de resolver problemas intrincados com um processo de pensamento passo a passo semelhante ao raciocínio humano. No entanto, apesar de seus recursos avançados, os LLMs têm desvantagens notáveis, incluindo altos custos computacionais e velocidades de implantação lenta, o que os torna menos viáveis para aplicativos do mundo real em configurações de recursos limitadas, como dispositivos móveis ou computação de borda. Isso despertou um grande interesse no desenvolvimento de modelos menores e mais eficientes que podem oferecer habilidades de raciocínio comparáveis, minimizando os custos e as demandas de recursos. Este artigo investiga o surgimento desses pequenos modelos de raciocínio, explorando seu potencial, desafios e as implicações futuras para a paisagem da IA.

Uma mudança de perspectiva

Por um período significativo na história recente da IA, o campo aderiu ao princípio das "leis de escala", que postula que o desempenho do modelo melhora previsivelmente como dados, potência de computação e aumento do tamanho do modelo. Embora essa abordagem tenha realmente produzido modelos poderosos, ela também levou a trade-offs consideráveis, como altos custos de infraestrutura, impacto ambiental e questões de latência. Nem todas as aplicações exigem todos os recursos de modelos maciços com centenas de bilhões de parâmetros. Em muitos cenários práticos-como assistentes de dispositivo, saúde e educação-os modelos pequenos podem obter resultados comparáveis, desde que possam raciocinar efetivamente.

Entendendo o raciocínio na IA

O raciocínio na IA abrange a capacidade de um modelo de seguir sequências lógicas, entender causa e efeito, deduzir implicações, planejar etapas processuais e identificar contradições. Para modelos de idiomas, isso envolve não apenas a recuperação de informações, mas também a manipulação e inferindo dados por meio de uma abordagem estruturada e passo a passo. Conseguir esse nível de raciocínio normalmente exige que os LLMs de ajuste fino realizem raciocínio em várias etapas antes de chegar a uma conclusão. Embora eficazes, esses métodos são intensivos em recursos e podem ser lentos e caros para implantar, levantando preocupações sobre sua acessibilidade e impacto ambiental.

Compreendendo pequenos modelos de raciocínio

Pequenos modelos de raciocínio visam replicar os recursos de raciocínio de grandes modelos, mas com maior eficiência em termos de poder computacional, uso de memória e latência. Esses modelos geralmente utilizam uma técnica conhecida como destilação de conhecimento, onde um modelo menor (o "aluno") aprende com um modelo maior e pré-treinado (o "professor"). O processo de destilação envolve o treinamento do modelo menor nos dados gerados pelo maior, com o objetivo de transferir a capacidade de raciocínio. O modelo do aluno é então ajustado para melhorar seu desempenho. Em alguns casos, o aprendizado de reforço com funções de recompensa específicas de domínio especializado é empregado para refinar ainda mais a capacidade do modelo de executar o raciocínio específico da tarefa.

A ascensão e avanços de pequenos modelos de raciocínio

Um momento crucial no desenvolvimento de pequenos modelos de raciocínio foi marcado pelo lançamento do Deepseek-R1. Treinado em um cluster relativamente modesto de GPUs mais antigas, o DeepSeek-R1 alcançou níveis de desempenho comparáveis a modelos maiores, como o OpenAI's O1 em benchmarks como MMLU e GSM-8K. Esse sucesso provocou uma reavaliação da abordagem tradicional de escala, que assumiu que modelos maiores eram inerentemente superiores.

O sucesso da Deepseek-R1 pode ser atribuído ao seu processo de treinamento inovador, que combinou o aprendizado de reforço em larga escala sem depender de ajustes finos supervisionados nos estágios iniciais. Essa inovação levou à criação do Deepseek-R1-Zero, um modelo que apresentou impressionantes recursos de raciocínio em comparação com grandes modelos de raciocínio. Aprimoramentos adicionais, como o uso de dados de início frio, melhoraram a coerência e a execução de tarefas do modelo, particularmente em áreas como matemática e codificação.

Além disso, as técnicas de destilação se mostraram instrumentais no desenvolvimento de modelos menores e mais eficientes de maiores. Por exemplo, a Deepseek lançou versões destiladas de seus modelos, variando em tamanho de 1,5 bilhão a 70 bilhões de parâmetros. Usando esses modelos, os pesquisadores treinaram um modelo significativamente menor, Deepseek-R1-Distill-Qwen-32b, que superou o OpenAI da O1-Mini em vários benchmarks. Agora, esses modelos são implantáveis em hardware padrão, tornando -os uma opção mais viável para uma ampla gama de aplicativos.

Os pequenos modelos podem combinar o raciocínio no nível GPT?

Para determinar se pequenos modelos de raciocínio (SRMS) podem corresponder ao poder de raciocínio de modelos grandes (LRMs) como o GPT, é crucial avaliar seu desempenho em benchmarks padrão. Por exemplo, o modelo Deepseek-R1 marcou em torno de 0,844 no teste MMLU, comparável a modelos maiores, como O1. No conjunto de dados GSM-8K, que se concentra na matemática da escola primária, o modelo destilado da Deepseek-R1 alcançou o desempenho de primeira linha, superando o O1 e o O1-mini.

Nas tarefas de codificação, como as do LivecodeBench e o CodeSorces, os modelos destilados do DeepSeek-R1 tiveram um desempenho semelhante ao O1-mini e GPT-4O, demonstrando fortes recursos de raciocínio na programação. No entanto, modelos maiores ainda têm uma vantagem nas tarefas que exigem uma compreensão mais ampla de idiomas ou lidando com janelas de contexto longo, pois modelos menores tendem a ser mais específicos de tarefas.

Apesar de seus pontos fortes, os pequenos modelos podem lutar com tarefas de raciocínio prolongadas ou diante de dados fora da distribuição. Por exemplo, nas simulações de xadrez LLM, o Deepseek-R1 cometeu mais erros do que os modelos maiores, indicando limitações em sua capacidade de manter o foco e a precisão por períodos prolongados.

Compensações e implicações práticas

As trocas entre tamanho e desempenho do modelo são críticas ao comparar SRMs com LRMs no nível GPT. Os modelos menores requerem menos memória e energia computacional, tornando -os ideais para dispositivos de borda, aplicativos móveis ou situações em que a inferência offline é necessária. Essa eficiência resulta em custos operacionais mais baixos, com modelos como o DeepSeek-R1 sendo até 96% mais barato do que modelos maiores como O1.

No entanto, esses ganhos de eficiência vêm com alguns compromissos. Os modelos menores geralmente são ajustados para tarefas específicas, o que pode limitar sua versatilidade em comparação com modelos maiores. Por exemplo, enquanto o Deepseek-R1 se destaca em matemática e codificação, ele não possui recursos multimodais, como a capacidade de interpretar imagens, que modelos maiores como o GPT-4O podem lidar.

Apesar dessas limitações, as aplicações práticas de pequenos modelos de raciocínio são extensos. Na área da saúde, eles podem alimentar ferramentas de diagnóstico que analisam dados médicos em servidores hospitalares padrão. Na educação, eles podem ser usados para desenvolver sistemas de tutoria personalizados, fornecendo feedback passo a passo aos alunos. Na pesquisa científica, eles podem ajudar na análise de dados e no teste de hipóteses em áreas como matemática e física. A natureza de código aberto de modelos como o Deepseek-R1 também promove a colaboração e democratiza o acesso à IA, permitindo que organizações menores se beneficiem de tecnologias avançadas.

A linha inferior

A evolução dos modelos de linguagem em modelos de raciocínio menor representa um avanço significativo na IA. Embora esses modelos ainda não correspondam completamente aos amplos recursos de grandes modelos de idiomas, eles oferecem vantagens importantes em eficiência, custo-efetividade e acessibilidade. Ao encontrar um equilíbrio entre poder de raciocínio e eficiência de recursos, os modelos menores estão prontos para desempenhar um papel crucial em várias aplicações, tornando a IA mais prática e sustentável para uso do mundo real.

-

Here Comes Impregno Man! Next Target is an American Wife

-

Prado Car Parking Game 2023

-

Scary Mansion: Jogo de Terror

-

Fabulous Las Vegas Mystery – Free Hidden Objects

-

Subway Icy Princess Rush Mod

-

HungryAliens

-

Chess Collection 2018

-

Harem

-

Bouncing Boobs Club

-

Diamond Lotto

-

Narde - Backgammon Free

-

Snakes And Ladders Star:2019 New Dice Game

-

1

![Lista de níveis de caracteres abandonados do Roblox [Atualizado] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Lista de níveis de caracteres abandonados do Roblox [Atualizado] (2025)

Mar 17,2025

-

2

Roblox Códigos limitados UGC revelados para janeiro de 2025

Jan 06,2025

-

3

Stardew Valley: Um guia completo para encantamentos e forjamento de armas

Jan 07,2025

-

4

Pokémon TCG Pocket: Solução de problemas de erro 102 resolvido

Jan 08,2025

-

5

Personagens de fogo grátis 2025: Ultimate Guide

Feb 20,2025

-

6

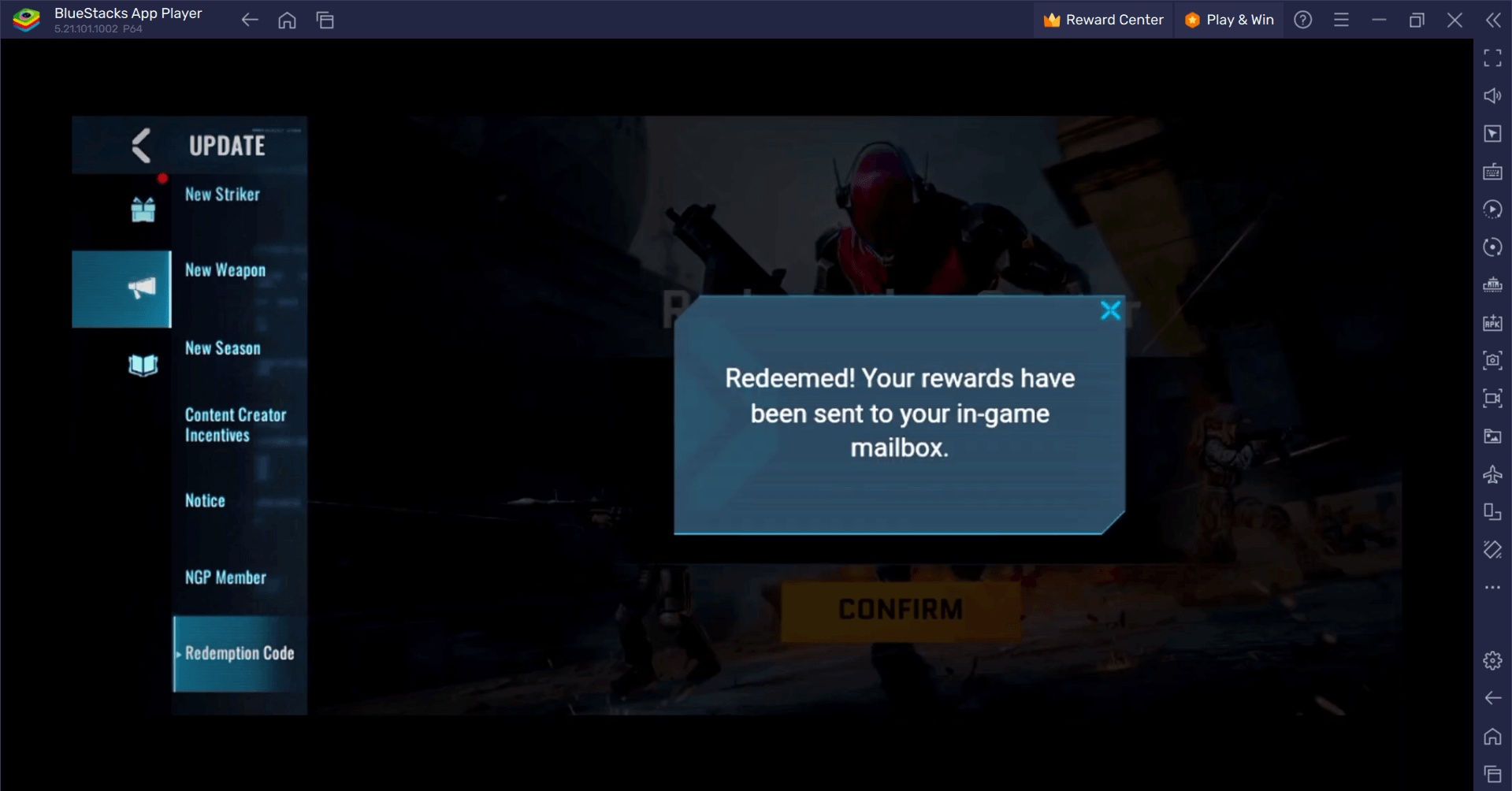

Blood Strike - Todos os códigos de resgate em funcionamento, janeiro de 2025

Jan 08,2025

-

7

Blue Archive Revela Evento Cibernético de Marcha de Ano Novo

Dec 19,2024

-

8

Roblox: Códigos RIVALS (janeiro de 2025)

Jan 07,2025

-

9

Cyber Quest: participe de batalhas de cartas cativantes no Android

Dec 19,2024

-

10

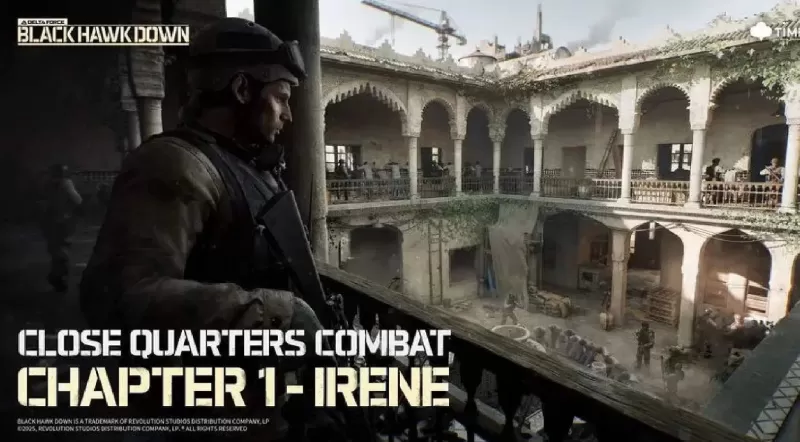

Delta Force: um guia completo para todas as missões de campanha

Apr 09,2025

-

Download

A Simple Life with My Unobtrusive Sister

Casual / 392.30M

Atualizar: Mar 27,2025

-

Download

Random fap scene

Casual / 20.10M

Atualizar: Dec 26,2024

-

Download

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

Casual / 486.00M

Atualizar: Dec 17,2024

-

4

Ben 10 A day with Gwen

-

5

Oniga Town of the Dead

-

6

A Wife And Mother

-

7

Cute Reapers in my Room Android

-

8

Permit Deny

-

9

Utouto Suyasuya

-

10

Roblox