कॉम्पैक्ट एआई की रीजनिंग पावर: चुनौतीपूर्ण जीपीटी?

हाल के वर्षों में, एआई समुदाय को बड़ी भाषा मॉडल (एलएलएम) की उल्लेखनीय उपलब्धियों से मोहित कर दिया गया है। मूल रूप से प्राकृतिक भाषा प्रसंस्करण के लिए तैयार की गई, इन मॉडलों ने परिष्कृत तर्क उपकरणों में बदल दिया है जो मानव तर्क के लिए एक कदम-दर-चरण विचार प्रक्रिया के साथ जटिल समस्याओं को हल करने में सक्षम हैं। हालांकि, उनकी उन्नत क्षमताओं के बावजूद, एलएलएम में उच्च कम्प्यूटेशनल लागत और धीमी परिनियोजन गति सहित उल्लेखनीय कमियां हैं, जो उन्हें मोबाइल डिवाइस या एज कंप्यूटिंग जैसे संसाधन-सीमित सेटिंग्स में वास्तविक दुनिया के अनुप्रयोगों के लिए कम संभव बनाते हैं। इसने छोटे, अधिक कुशल मॉडल के विकास में गहरी रुचि पैदा की है जो लागत और संसाधन मांगों को कम करते हुए तुलनीय तर्क क्षमता प्रदान कर सकते हैं। यह लेख इन छोटे तर्क मॉडल के उद्भव में, उनकी क्षमता, चुनौतियों और एआई परिदृश्य के लिए भविष्य के निहितार्थों की खोज करता है।

परिप्रेक्ष्य में एक बदलाव

एआई के हालिया इतिहास में एक महत्वपूर्ण अवधि के लिए, क्षेत्र ने "स्केलिंग कानूनों" के सिद्धांत का पालन किया है, जो यह बताता है कि मॉडल प्रदर्शन डेटा, गणना शक्ति और मॉडल आकार में वृद्धि के रूप में अनुमानित रूप से सुधार करता है। जबकि इस दृष्टिकोण ने वास्तव में शक्तिशाली मॉडल का उत्पादन किया है, इसने काफी व्यापार-बंदों को भी जन्म दिया है, जैसे कि उच्च बुनियादी ढांचा लागत, पर्यावरणीय प्रभाव और विलंबता मुद्दे। सभी अनुप्रयोगों को सैकड़ों अरबों मापदंडों के साथ बड़े पैमाने पर मॉडल की पूरी क्षमताओं की आवश्यकता नहीं है। कई व्यावहारिक परिदृश्यों में-जैसे कि ऑन-डिवाइस असिस्टेंट, हेल्थकेयर, और शिक्षा-स्मालर मॉडल तुलनीय परिणाम प्राप्त कर सकते हैं, बशर्ते वे प्रभावी रूप से तर्क कर सकें।

एआई में तर्क को समझना

AI में तर्क तार्किक अनुक्रमों का पालन करने, कारण और प्रभाव को समझने, निहितार्थों को कम करने, प्रक्रियात्मक चरणों की योजना बनाने और विरोधाभासों की पहचान करने के लिए एक मॉडल की क्षमता को शामिल करता है। भाषा मॉडल के लिए, इसमें न केवल जानकारी प्राप्त करना शामिल है, बल्कि एक संरचित, चरण-दर-चरण दृष्टिकोण के माध्यम से डेटा में हेरफेर करना और उसका उल्लेख करना भी शामिल है। तर्क के इस स्तर को प्राप्त करने के लिए आमतौर पर एक निष्कर्ष पर पहुंचने से पहले बहु-चरणीय तर्क करने के लिए ठीक-ट्यूनिंग एलएलएम की आवश्यकता होती है। प्रभावी होते हुए, ये विधियां संसाधन-गहन हैं और उनकी पहुंच और पर्यावरणीय प्रभाव के बारे में चिंताओं को बढ़ाते हुए, तैनात करने के लिए धीमी और महंगी हो सकती हैं।

छोटे तर्क मॉडल को समझना

छोटे तर्क मॉडल का उद्देश्य बड़े मॉडलों की तर्क क्षमताओं को दोहराना है, लेकिन कम्प्यूटेशनल पावर, मेमोरी उपयोग और विलंबता के संदर्भ में अधिक दक्षता के साथ। ये मॉडल अक्सर ज्ञान आसवन के रूप में जानी जाने वाली एक तकनीक का उपयोग करते हैं, जहां एक छोटा मॉडल ("छात्र") एक बड़े, पूर्व-प्रशिक्षित मॉडल ("शिक्षक") से सीखता है। आसवन प्रक्रिया में बड़े द्वारा उत्पन्न डेटा पर छोटे मॉडल को प्रशिक्षित करना शामिल है, जिसका उद्देश्य तर्क क्षमता को स्थानांतरित करना है। छात्र मॉडल तब अपने प्रदर्शन को बढ़ाने के लिए ठीक-ठाक है। कुछ उदाहरणों में, विशेष डोमेन-विशिष्ट इनाम कार्यों के साथ सुदृढीकरण सीखने को कार्य-विशिष्ट तर्क करने के लिए मॉडल की क्षमता को और परिष्कृत करने के लिए नियोजित किया जाता है।

छोटे तर्क मॉडल की वृद्धि और प्रगति

छोटे तर्क मॉडल के विकास में एक महत्वपूर्ण क्षण को डीपसेक-आर 1 की रिहाई द्वारा चिह्नित किया गया था। पुराने जीपीयू के अपेक्षाकृत मामूली क्लस्टर पर प्रशिक्षित, डीपसेक-आर 1 ने एमएमएलयू और जीएसएम -8 के जैसे बेंचमार्क पर ओपनआईए के ओ 1 जैसे बड़े मॉडलों की तुलना में प्रदर्शन का स्तर हासिल किया। इस सफलता ने पारंपरिक स्केलिंग दृष्टिकोण के पुनर्मूल्यांकन को प्रेरित किया है, जिसमें माना गया है कि बड़े मॉडल स्वाभाविक रूप से बेहतर थे।

दीपसेक-आर 1 की सफलता को इसकी अभिनव प्रशिक्षण प्रक्रिया के लिए जिम्मेदार ठहराया जा सकता है, जिसने शुरुआती चरणों में पर्यवेक्षित फाइन-ट्यूनिंग पर भरोसा किए बिना बड़े पैमाने पर सुदृढीकरण सीखने को संयुक्त किया। इस नवाचार ने दीपसेक-आर 1-जीरो के निर्माण का नेतृत्व किया, एक मॉडल जो बड़े तर्क मॉडल की तुलना में प्रभावशाली तर्क क्षमताओं का प्रदर्शन करता है। आगे बढ़ाने, जैसे कि कोल्ड-स्टार्ट डेटा का उपयोग, विशेष रूप से गणित और कोडिंग जैसे क्षेत्रों में मॉडल के सुसंगतता और कार्य निष्पादन में सुधार हुआ।

इसके अतिरिक्त, आसवन तकनीकों ने बड़े लोगों से छोटे, अधिक कुशल मॉडल विकसित करने में महत्वपूर्ण साबित किया है। उदाहरण के लिए, दीपसेक ने अपने मॉडलों के डिस्टिल्ड संस्करण जारी किए हैं, जो आकार में 1.5 बिलियन से 70 बिलियन मापदंडों तक हैं। इन मॉडलों का उपयोग करते हुए, शोधकर्ताओं ने काफी छोटे मॉडल, डीपसेक-आर 1-डिस्टिल-क्वेन -32 बी को प्रशिक्षित किया है, जिसने विभिन्न बेंचमार्क में ओपनईएआई के ओ 1-मिनी को बेहतर बनाया है। ये मॉडल अब मानक हार्डवेयर पर तैनात हैं, जिससे वे अनुप्रयोगों की एक विस्तृत श्रृंखला के लिए अधिक व्यवहार्य विकल्प बन जाते हैं।

क्या छोटे मॉडल जीपीटी-स्तरीय तर्क से मेल खा सकते हैं?

यह निर्धारित करने के लिए कि क्या छोटे तर्क मॉडल (SRM) GPT जैसे बड़े मॉडल (LRMs) की तर्क शक्ति से मेल खा सकते हैं, यह मानक बेंचमार्क पर उनके प्रदर्शन का मूल्यांकन करना महत्वपूर्ण है। उदाहरण के लिए, डीपसेक-आर 1 मॉडल ने एमएमएलयू परीक्षण पर लगभग 0.844 स्कोर किया, जैसे कि ओ 1 जैसे बड़े मॉडलों की तुलना में। GSM-8K डेटासेट पर, जो ग्रेड-स्कूल गणित पर केंद्रित है, DeepSeek-R1 के डिस्टिल्ड मॉडल ने O1 और O1-Mini दोनों को पार करते हुए, शीर्ष स्तरीय प्रदर्शन प्राप्त किया।

कोडिंग कार्यों में, जैसे कि LiveCodebench और Codeforces पर, DeepSeek-R1 के डिस्टिल्ड मॉडल ने O1-MINI और GPT-4O के समान प्रदर्शन किया, प्रोग्रामिंग में मजबूत तर्क क्षमताओं का प्रदर्शन किया। हालांकि, बड़े मॉडलों को अभी भी व्यापक भाषा की समझ या लंबे संदर्भ खिड़कियों को संभालने वाले कार्यों में एक फायदा है, क्योंकि छोटे मॉडल अधिक कार्य-विशिष्ट होते हैं।

अपनी ताकत के बावजूद, छोटे मॉडल विस्तारित तर्क कार्यों के साथ संघर्ष कर सकते हैं या जब आउट-ऑफ-डिस्ट्रिब्यूशन डेटा के साथ सामना कर सकते हैं। उदाहरण के लिए, एलएलएम शतरंज सिमुलेशन में, डीपसेक-आर 1 ने बड़े मॉडलों की तुलना में अधिक गलतियाँ कीं, जो विस्तारित अवधि पर फोकस और सटीकता बनाए रखने की अपनी क्षमता में सीमाओं का संकेत देते हैं।

व्यापार बंद और व्यावहारिक निहितार्थ

जीपीटी-स्तरीय एलआरएम के साथ एसआरएम की तुलना करते समय मॉडल आकार और प्रदर्शन के बीच व्यापार-बंद महत्वपूर्ण हैं। छोटे मॉडल को कम मेमोरी और कम्प्यूटेशनल पावर की आवश्यकता होती है, जिससे वे एज डिवाइसेस, मोबाइल ऐप्स या उन स्थितियों के लिए आदर्श बन जाते हैं जहां ऑफ़लाइन अनुमान आवश्यक है। इस दक्षता के परिणामस्वरूप कम परिचालन लागत होती है, जिसमें डीपसेक-आर 1 जैसे मॉडल O1 जैसे बड़े मॉडलों की तुलना में 96% तक सस्ते होते हैं।

हालांकि, ये दक्षता लाभ कुछ समझौते के साथ आते हैं। छोटे मॉडल आमतौर पर विशिष्ट कार्यों के लिए ठीक-ठीक होते हैं, जो बड़े मॉडलों की तुलना में उनकी बहुमुखी प्रतिभा को सीमित कर सकते हैं। उदाहरण के लिए, जबकि डीपसेक-आर 1 गणित और कोडिंग में एक्सेल करता है, इसमें मल्टीमॉडल क्षमताओं का अभाव है, जैसे कि छवियों की व्याख्या करने की क्षमता, जो जीपीटी -4 ओ जैसे बड़े मॉडल संभाल सकते हैं।

इन सीमाओं के बावजूद, छोटे तर्क मॉडल के व्यावहारिक अनुप्रयोग व्यापक हैं। हेल्थकेयर में, वे नैदानिक उपकरणों को बिजली दे सकते हैं जो मानक अस्पताल सर्वर पर चिकित्सा डेटा का विश्लेषण करते हैं। शिक्षा में, उनका उपयोग व्यक्तिगत ट्यूशन सिस्टम विकसित करने के लिए किया जा सकता है, जो छात्रों को चरण-दर-चरण प्रतिक्रिया प्रदान करता है। वैज्ञानिक अनुसंधान में, वे गणित और भौतिकी जैसे क्षेत्रों में डेटा विश्लेषण और परिकल्पना परीक्षण के साथ सहायता कर सकते हैं। डीपसेक-आर 1 जैसे मॉडलों की ओपन-सोर्स प्रकृति भी सहयोग को बढ़ावा देती है और एआई तक पहुंच का लोकतंत्रीकरण करती है, जिससे छोटे संगठनों को उन्नत प्रौद्योगिकियों से लाभ होता है।

तल - रेखा

छोटे तर्क मॉडल में भाषा मॉडल का विकास एआई में एक महत्वपूर्ण उन्नति का प्रतिनिधित्व करता है। हालांकि ये मॉडल अभी तक बड़ी भाषा मॉडल की व्यापक क्षमताओं से पूरी तरह से मेल नहीं खा सकते हैं, वे दक्षता, लागत-प्रभावशीलता और पहुंच में महत्वपूर्ण लाभ प्रदान करते हैं। तर्क शक्ति और संसाधन दक्षता के बीच एक संतुलन बनाने से, छोटे मॉडल विभिन्न अनुप्रयोगों में एक महत्वपूर्ण भूमिका निभाने के लिए तैयार हैं, जिससे एआई वास्तविक दुनिया के उपयोग के लिए अधिक व्यावहारिक और टिकाऊ हो जाता है।

-

1

Stardew Valley: जादू और हथियार बनाने के लिए एक संपूर्ण मार्गदर्शिका

Jan 07,2025

-

2

Roblox जनवरी 2025 के लिए यूजीसी लिमिटेड कोड का अनावरण किया गया

Jan 06,2025

-

3

पोकेमॉन टीसीजी पॉकेट: समस्या निवारण त्रुटि 102 का समाधान हो गया

Jan 08,2025

-

4

Blue Archive साइबर नव वर्ष मार्च कार्यक्रम का अनावरण किया

Dec 19,2024

-

5

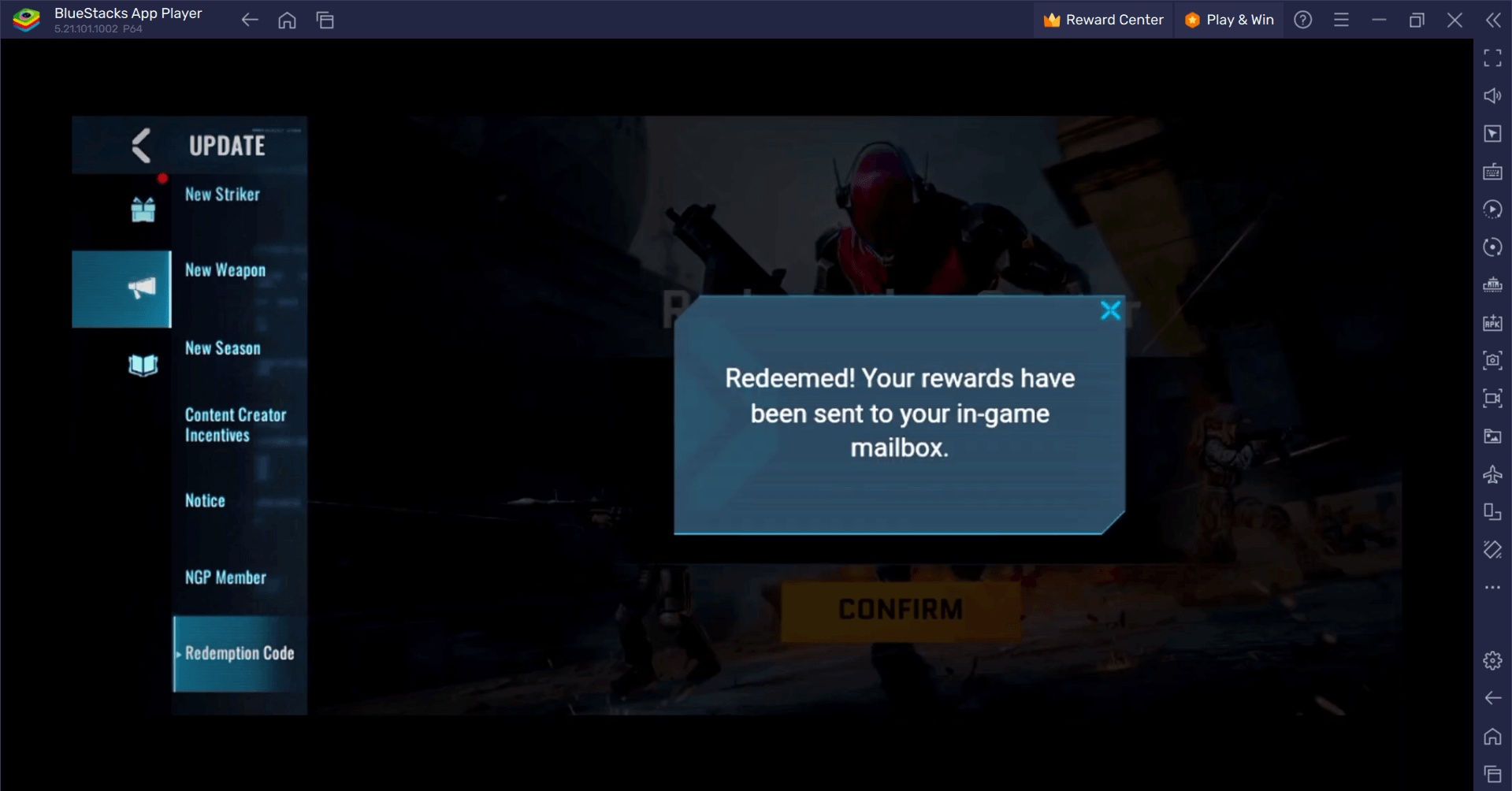

ब्लड स्ट्राइक - सभी वर्किंग रिडीम कोड जनवरी 2025

Jan 08,2025

-

6

साइबर क्वेस्ट: एंड्रॉइड पर मनोरम कार्ड बैटल में संलग्न रहें

Dec 19,2024

-

7

![Roblox Forsaken वर्णों की सूची [अद्यतन] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Roblox Forsaken वर्णों की सूची [अद्यतन] (2025)

Mar 17,2025

-

8

बार्ट बोंटे ने एक नई पहेली छोड़ी मिस्टर एंटोनियो जहां आप एक बिल्ली के लिए 'फ़ेच' खेलते हैं!

Dec 18,2024

-

9

Sony नए Midnight ब्लैक PS5 एक्सेसरीज़ का खुलासा

Jan 08,2025

-

10

Roblox: प्रतिद्वंद्वी कोड (जनवरी 2025)

Jan 07,2025

-

डाउनलोड करना

Random fap scene

अनौपचारिक / 20.10M

अद्यतन: Dec 26,2024

-

डाउनलोड करना

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

अनौपचारिक / 486.00M

अद्यतन: Dec 17,2024

-

डाउनलोड करना

Roblox

वैयक्तिकरण / 127.00M

अद्यतन: Oct 21,2021

-

4

A Simple Life with My Unobtrusive Sister

-

5

Ben 10 A day with Gwen

-

6

A Wife And Mother

-

7

Permit Deny

-

8

Oniga Town of the Dead

-

9

Cute Reapers in my Room Android

-

10

Piano White Go! - Piano Games Tiles