Kekuatan Penaakulan AI Kompak: Mencabar GPT?

Dalam tahun -tahun kebelakangan ini, komuniti AI telah terpesona oleh pencapaian yang luar biasa model bahasa besar (LLM). Awalnya dibuat untuk pemprosesan bahasa semulajadi, model-model ini telah berubah menjadi alat penalaran yang canggih yang mampu menyelesaikan masalah yang rumit dengan proses pemikiran langkah demi langkah yang serupa dengan penalaran manusia. Walau bagaimanapun, walaupun keupayaan maju mereka, LLM mempunyai kelemahan yang ketara, termasuk kos pengiraan yang tinggi dan kelajuan penempatan yang perlahan, yang menjadikan mereka kurang layak untuk aplikasi dunia nyata dalam tetapan terhad sumber seperti peranti mudah alih atau pengkomputeran tepi. Ini telah mencetuskan minat yang mendalam dalam pembangunan model yang lebih kecil dan lebih cekap yang dapat memberikan kebolehan penalaran yang setanding sambil meminimumkan kos dan permintaan sumber. Artikel ini menyelidiki kemunculan model penalaran kecil ini, meneroka potensi, cabaran, dan implikasi masa depan untuk landskap AI.

Pergeseran Perspektif

Untuk tempoh yang signifikan dalam sejarah AI baru -baru ini, bidang ini telah mematuhi prinsip "undang -undang skala," yang menimbulkan prestasi model yang diperbaiki sebagai data, kuasa pengiraan, dan peningkatan saiz model. Walaupun pendekatan ini sememangnya menghasilkan model yang kuat, ia juga telah membawa kepada perdagangan yang besar, seperti kos infrastruktur yang tinggi, kesan alam sekitar, dan isu latensi. Tidak semua aplikasi memerlukan keupayaan penuh model besar -besaran dengan beratus -ratus berbilion parameter. Dalam banyak senario praktikal-seperti pembantu di peranti, penjagaan kesihatan, dan model-model yang boleh dicapai dapat mencapai hasil yang setanding, dengan syarat mereka dapat alasan dengan berkesan.

Memahami Penalaran di AI

Penalaran dalam AI merangkumi keupayaan model untuk mengikuti urutan logik, memahami sebab dan akibat, menyimpulkan implikasi, pelan langkah -langkah prosedur, dan mengenal pasti percanggahan. Untuk model bahasa, ini melibatkan bukan sahaja mendapatkan maklumat tetapi juga memanipulasi dan menyimpulkan data melalui pendekatan berstruktur, langkah demi langkah. Mencapai tahap penalaran ini biasanya memerlukan LLM yang baik untuk melakukan penalaran pelbagai langkah sebelum mencapai kesimpulan. Walaupun berkesan, kaedah ini berintensifkan sumber dan boleh perlahan dan mahal untuk digunakan, menimbulkan kebimbangan mengenai akses dan kesan alam sekitar mereka.

Memahami model penalaran kecil

Model penalaran kecil bertujuan untuk meniru keupayaan pemikiran model besar tetapi dengan kecekapan yang lebih besar dari segi kuasa pengiraan, penggunaan memori, dan latensi. Model-model ini sering menggunakan teknik yang dikenali sebagai penyulingan pengetahuan, di mana model yang lebih kecil ("pelajar") belajar dari model yang lebih besar dan terlatih ("guru"). Proses penyulingan melibatkan latihan model yang lebih kecil pada data yang dihasilkan oleh yang lebih besar, yang bertujuan untuk memindahkan keupayaan penalaran. Model pelajar kemudian disesuaikan untuk meningkatkan prestasinya. Dalam sesetengah keadaan, pembelajaran tetulang dengan fungsi ganjaran khusus domain khusus digunakan untuk memperbaiki keupayaan model untuk melaksanakan penalaran khusus tugas.

Kenaikan dan kemajuan model penalaran kecil

Momen penting dalam pembangunan model penalaran kecil ditandai dengan pembebasan DeepSeek-R1. Dilatih pada kelompok GPU yang lebih sederhana, DeepSeek-R1 mencapai tahap prestasi yang setanding dengan model yang lebih besar seperti Openai's O1 pada tanda aras seperti MMLU dan GSM-8K. Kejayaan ini telah mendorong penilaian semula pendekatan skala tradisional, yang mengandaikan bahawa model yang lebih besar adalah lebih baik.

Kejayaan DeepSeek-R1 dapat dikaitkan dengan proses latihan inovatifnya, yang menggabungkan pembelajaran tetulang berskala besar tanpa bergantung pada penalaan yang diselia di peringkat awal. Inovasi ini membawa kepada penciptaan DeepSeek-R1-Zero, model yang mempamerkan keupayaan penalaran yang mengagumkan berbanding dengan model penalaran yang besar. Peningkatan selanjutnya, seperti penggunaan data permulaan sejuk, meningkatkan koheren model dan pelaksanaan tugas, terutamanya dalam bidang seperti matematik dan pengekodan.

Di samping itu, teknik penyulingan telah terbukti penting dalam membangunkan model yang lebih kecil dan lebih cekap daripada yang lebih besar. Sebagai contoh, DeepSeek telah mengeluarkan versi suling modelnya, dari saiz dari 1.5 bilion hingga 70 bilion parameter. Dengan menggunakan model-model ini, penyelidik telah melatih model yang lebih kecil, DeepSeek-R1-Distill-Qwen-32b, yang telah mengatasi Openai's O1-mini di pelbagai tanda aras. Model -model ini kini boleh digunakan pada perkakasan standard, menjadikannya pilihan yang lebih baik untuk pelbagai aplikasi.

Bolehkah model kecil sepadan dengan penalaran peringkat GPT?

Untuk menentukan sama ada model penalaran kecil (SRMS) boleh memadankan kuasa pemikiran model besar (LRM) seperti GPT, adalah penting untuk menilai prestasi mereka pada tanda aras standard. Sebagai contoh, model DeepSeek-R1 menjaringkan sekitar 0.844 pada ujian MMLU, setanding dengan model yang lebih besar seperti O1. Mengenai dataset GSM-8K, yang memberi tumpuan kepada matematik sekolah gred, model sulingan DeepSeek-R1 mencapai prestasi teratas, melepasi O1 dan O1-Mini.

Dalam tugas pengekodan, seperti yang di LiveCodeBench dan Codeforces, model sulingan DeepSeek-R1 dilakukan sama seperti O1-Mini dan GPT-4O, menunjukkan keupayaan penalaran yang kuat dalam pengaturcaraan. Walau bagaimanapun, model yang lebih besar masih mempunyai kelebihan dalam tugas yang memerlukan pemahaman bahasa yang lebih luas atau mengendalikan tingkap konteks yang panjang, kerana model yang lebih kecil cenderung lebih khusus tugas.

Walaupun kekuatan mereka, model kecil boleh berjuang dengan tugas-tugas penalaran yang panjang atau ketika berhadapan dengan data luar-pengedaran. Sebagai contoh, dalam simulasi catur LLM, DeepSeek-R1 membuat lebih banyak kesilapan daripada model yang lebih besar, menunjukkan batasan dalam keupayaannya untuk mengekalkan tumpuan dan ketepatan dalam tempoh yang panjang.

Perdagangan dan implikasi praktikal

Perdagangan antara saiz model dan prestasi adalah kritikal apabila membandingkan SRM dengan LRM peringkat GPT. Model yang lebih kecil memerlukan kurang memori dan kuasa pengiraan, menjadikannya sesuai untuk peranti kelebihan, aplikasi mudah alih, atau situasi di mana kesimpulan luar talian diperlukan. Kecekapan ini menghasilkan kos operasi yang lebih rendah, dengan model seperti DeepSeek-R1 sehingga 96% lebih murah untuk dijalankan daripada model yang lebih besar seperti O1.

Walau bagaimanapun, keuntungan kecekapan ini datang dengan beberapa kompromi. Model yang lebih kecil biasanya disesuaikan dengan tugas-tugas tertentu, yang boleh mengehadkan fleksibiliti mereka berbanding dengan model yang lebih besar. Sebagai contoh, sementara DeepSeek-R1 cemerlang dalam matematik dan pengekodan, ia tidak mempunyai keupayaan multimodal, seperti keupayaan untuk mentafsir imej, yang model yang lebih besar seperti GPT-4O dapat mengendalikan.

Walaupun terdapat batasan -batasan ini, aplikasi praktikal model penalaran kecil adalah luas. Dalam penjagaan kesihatan, mereka boleh menguasai alat diagnostik yang menganalisis data perubatan pada pelayan hospital standard. Dalam pendidikan, mereka boleh digunakan untuk membangunkan sistem tunjuk ajar yang diperibadikan, memberikan maklum balas langkah demi langkah kepada pelajar. Dalam penyelidikan saintifik, mereka boleh membantu analisis data dan ujian hipotesis dalam bidang seperti matematik dan fizik. Sifat sumber terbuka model seperti DeepSeek-R1 juga memupuk kerjasama dan demokrasi akses kepada AI, membolehkan organisasi yang lebih kecil mendapat manfaat daripada teknologi canggih.

Garis bawah

Evolusi model bahasa ke dalam model penalaran yang lebih kecil mewakili kemajuan yang ketara dalam AI. Walaupun model-model ini mungkin belum sepenuhnya sepadan dengan keupayaan luas model bahasa yang besar, mereka menawarkan kelebihan utama dalam kecekapan, keberkesanan kos, dan aksesibiliti. Dengan menarik keseimbangan antara kuasa pemikiran dan kecekapan sumber, model yang lebih kecil bersedia untuk memainkan peranan penting dalam pelbagai aplikasi, menjadikan AI lebih praktikal dan mampan untuk kegunaan dunia nyata.

-

1

Stardew Valley: Panduan Lengkap Untuk Jimat & Penempaan Senjata

Jan 07,2025

-

2

Roblox Kod Terhad UGC Didedahkan untuk Januari 2025

Jan 06,2025

-

3

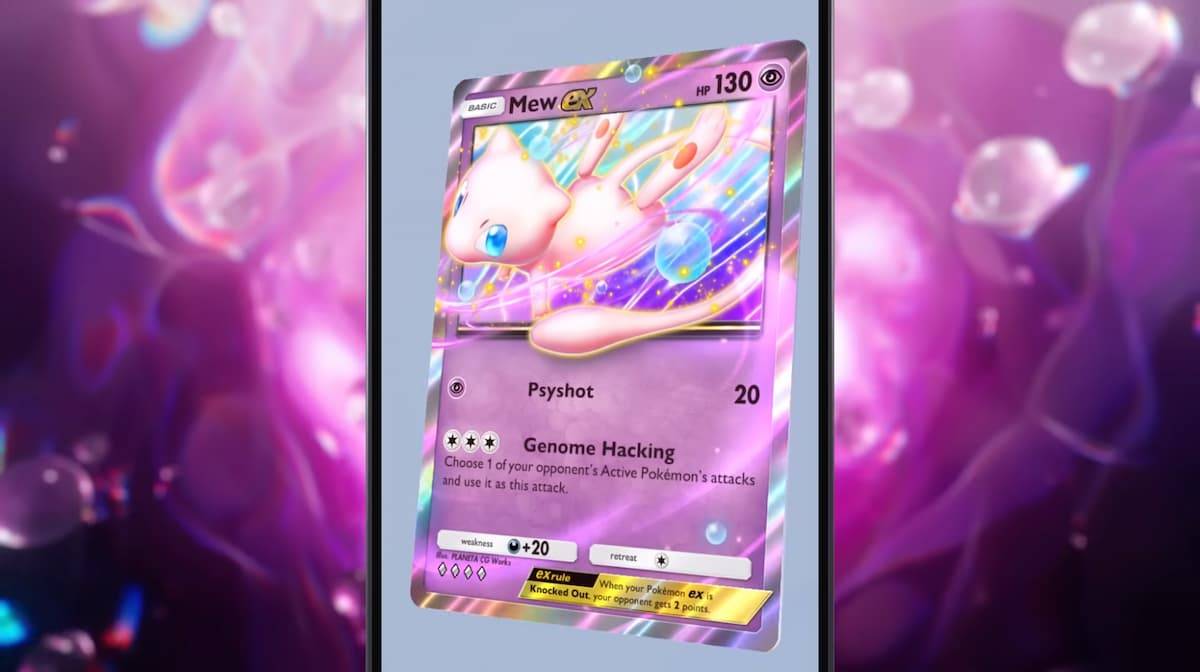

Poket TCG Pokémon: Ralat Penyelesaian Masalah 102 Selesai

Jan 08,2025

-

4

Blue Archive Memperkenalkan Acara Mac Tahun Baru Siber

Dec 19,2024

-

5

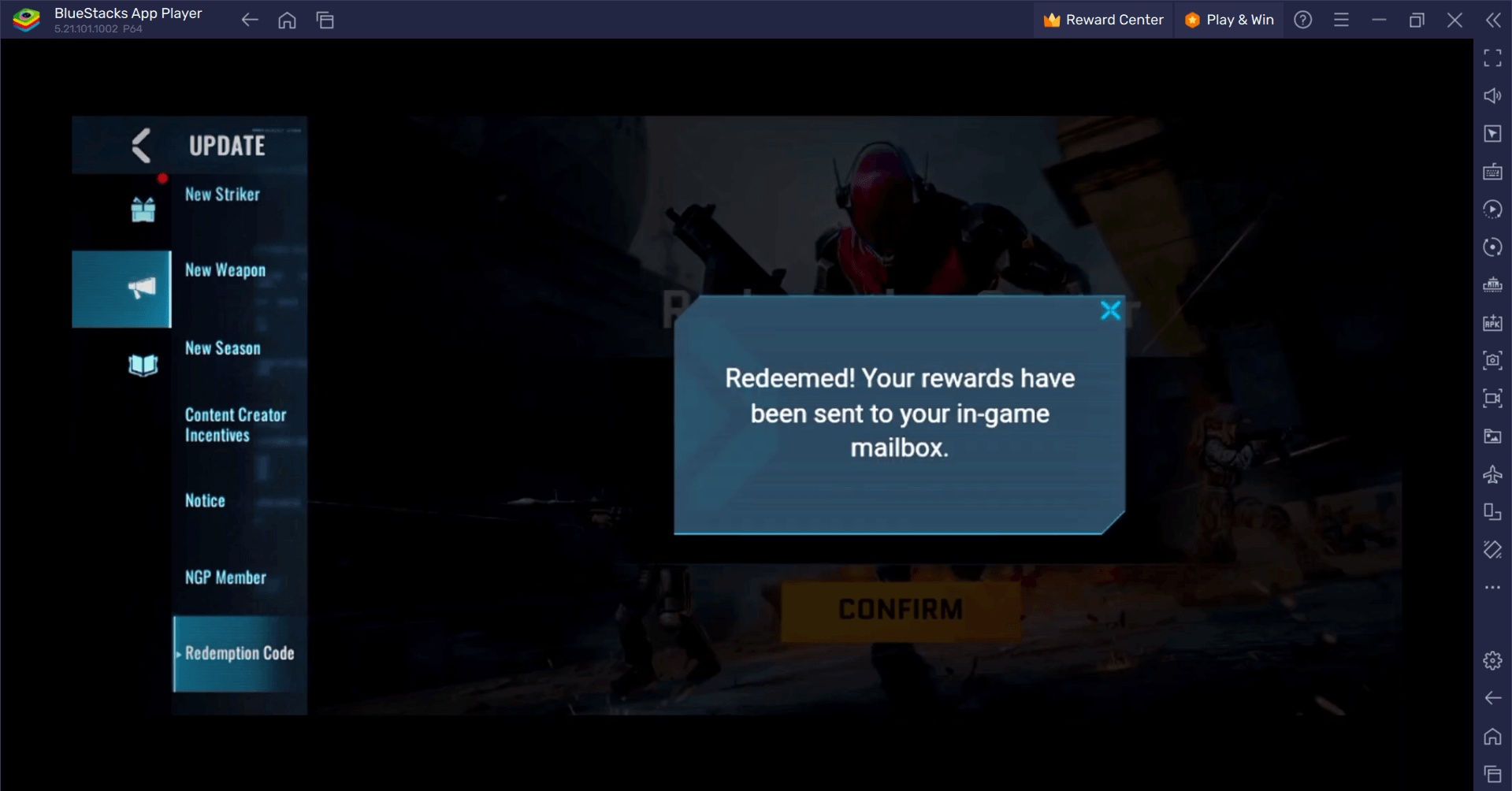

Blood Strike - Semua Kod Penebusan Berfungsi Januari 2025

Jan 08,2025

-

6

Pencarian Siber: Terlibat dalam Pertempuran Kad Menawan pada Android

Dec 19,2024

-

7

![Senarai Tahap Roblox Forsaken [Dikemaskini] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Senarai Tahap Roblox Forsaken [Dikemaskini] (2025)

Mar 17,2025

-

8

Sony Mendedahkan Baharu Midnight Aksesori PS5 Hitam

Jan 08,2025

-

9

Bart Bonte Mengeluarkan Teka-teki Baharu Tuan Antonio Di Mana Anda Bermain Ambil 'Untuk' Kucing!

Dec 18,2024

-

10

Roblox: Kod RIVALS (Januari 2025)

Jan 07,2025

-

Muat turun

Random fap scene

Santai / 20.10M

Kemas kini: Dec 26,2024

-

Muat turun

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

Santai / 486.00M

Kemas kini: Dec 17,2024

-

Muat turun

Arceus X script

Pemperibadian / 127.00M

Kemas kini: Oct 21,2021

-

4

A Simple Life with My Unobtrusive Sister

-

5

Ben 10 A day with Gwen

-

6

A Wife And Mother

-

7

Permit Deny

-

8

Oniga Town of the Dead

-

9

Cute Reapers in my Room Android

-

10

Piano White Go! - Piano Games Tiles