Dom > Aktualności > Kompaktowa AI Moc rozumowania: rzucający wyzwanie GPT?

Kompaktowa AI Moc rozumowania: rzucający wyzwanie GPT?

W ostatnich latach społeczność AI była zafascynowana niezwykłymi osiągnięciami dużych modeli językowych (LLM). Modele te, pierwotnie stworzone do przetwarzania języka naturalnego, przekształciły się w wyrafinowane narzędzia rozumowania zdolne do rozwiązywania skomplikowanych problemów z procesem myślowym krok po kroku podobnym do ludzkiego rozumowania. Jednak pomimo ich zaawansowanych możliwości, LLM mają znaczące wady, w tym wysokie koszty obliczeniowe i powolne prędkości wdrażania, co czyni je mniej wykonalnymi dla rzeczywistych aplikacji w ustawieniach ograniczonych zasobów, takich jak urządzenia mobilne lub przetwarzanie krawędzi. To wzbudziło zainteresowanie rozwojem mniejszych, bardziej wydajnych modeli, które mogą zapewnić porównywalne umiejętności rozumowania, jednocześnie minimalizując koszty i zapotrzebowanie na zasoby. Ten artykuł zagłębia się nad pojawieniem się tych małych modeli rozumowania, badając ich potencjał, wyzwania i przyszłe konsekwencje dla krajobrazu AI.

Zmiana perspektywy

Przez znaczny okres w najnowszej historii AI pole przestrzegowało zasadę „przepisów dotyczących skalowania”, która zakłada, że wydajność modelu poprawia się, gdy zwiększa się dane, moc obliczeniowa i wielkość modelu. Chociaż takie podejście rzeczywiście opracowało potężne modele, doprowadziło również do znacznych kompromisów, takich jak wysokie koszty infrastruktury, wpływ na środowisko i problemy związane z opóźnieniem. Nie wszystkie aplikacje wymagają pełnych możliwości masowych modeli z setkami miliardów parametrów. W wielu praktycznych scenariuszach-takich jak asystenci na urządzeniu, opieka zdrowotna i edukacja-modele małżeństwo mogą osiągnąć porównywalne wyniki, pod warunkiem, że mogą one skutecznie rozumować.

Zrozumienie rozumowania w sztucznej inteligencji

Rozumowanie w AI obejmuje zdolność modelu do przestrzegania sekwencji logicznych, zrozumienia przyczyny i skutku, wywnioskowania implikacji, planowania kroków proceduralnych i identyfikacji sprzeczności. W przypadku modeli językowych wymaga to nie tylko pobierania informacji, ale także manipulowania i wnioskowaniem danych poprzez ustrukturyzowane podejście krok po kroku. Osiągnięcie tego poziomu rozumowania zazwyczaj wymaga dopracowania LLM, aby wykonać wieloetapowe rozumowanie przed wyciągnięciem wniosków. Choć skuteczne, te metody są wymagające zasobów i mogą być powolne i kosztowne wdrażanie, zwiększając obawy dotyczące ich dostępności i wpływu na środowisko.

Zrozumienie małych modeli rozumowania

Modne modele rozumowania mają na celu powtórzenie możliwości rozumowania dużych modeli, ale z większą wydajnością pod względem mocy obliczeniowej, zużycia pamięci i opóźnień. Modele te często wykorzystują technikę znaną jako destylacja wiedzy, w której mniejszy model („uczeń”) uczy się z większego, wstępnie wyszkolonego modelu („nauczyciela”). Proces destylacji obejmuje szkolenie mniejszego modelu na danych generowanych przez większy, mając na celu przeniesienie zdolności rozumowania. Model studencki jest następnie dopracowany, aby poprawić jego wydajność. W niektórych przypadkach uczenie się wzmocnienia z specjalistycznymi funkcjami nagrody specyficzne dla domeny jest stosowane w celu dalszego udoskonalenia zdolności modelu do wykonywania rozumowania specyficznego dla zadania.

Wzrost i postępy małych modeli rozumowania

Kluczowy moment w opracowywaniu małych modeli rozumowania charakteryzował się wydaniem Deepseek-R1. Wyszkolony w stosunkowo skromnym klastrze starszych GPU, Deepseek-R1 osiągnął poziomy wydajności porównywalne z większymi modelami, takimi jak O1 Openai na testach porównawczych, takich jak MMLU i GSM-8K. Sukces ten spowodował ponowną ocenę tradycyjnego podejścia skalowania, które założyło, że większe modele były z natury lepsze.

Sukces DeepSeek-R1 można przypisać innowacyjnego procesu szkoleniowego, który połączył naukę wzmocnienia na dużą skalę bez polegania na nadzorowanym dostrajaniu na wczesnych etapach. Ta innowacja doprowadziła do stworzenia Deepseek-R1-Zero, modelu, który pokazywał imponujące możliwości rozumowania w porównaniu z dużymi modelami rozumowania. Dalsze ulepszenia, takie jak wykorzystanie danych na zimno, poprawiły spójność i wykonywanie zadań modelu, szczególnie w obszarach takich jak matematyka i kodowanie.

Ponadto techniki destylacji okazały się instrumentalne w opracowywaniu mniejszych, bardziej wydajnych modeli z większych. Na przykład Deepseek wydał destylowane wersje swoich modeli, o wielkości od 1,5 miliarda do 70 miliardów parametrów. Korzystając z tych modeli, naukowcy przeszkolili znacznie mniejszy model, Deepseek-R1-Distill-Qwen-32B, który przewyższył O1-Mini Openai na różnych testach porównawczych. Modele te można teraz wdrażać na standardowym sprzęcie, co czyni je bardziej opłacalną opcją dla szerokiej gamy aplikacji.

Czy małe modele mogą dopasować rozumowanie na poziomie GPT?

Aby ustalić, czy małe modele rozumowania (SRM) mogą pasować do mocy rozumowania dużych modeli (LRM), takich jak GPT, kluczowe jest ocena ich wydajności na standardowych testach porównawczych. Na przykład model DeepSeek-R1 uzyskał około 0,844 w teście MMLU, porównywalnym z większymi modelami, takimi jak O1. Na zestawie danych GSM-8K, który koncentruje się na matematyce szkół klasy, model destylowany DeepSeek-R1 osiągnął wydajność najwyższego poziomu, przewyższając zarówno O1, jak i O1-Mini.

W zadaniach kodowania, takich jak te na LiveCodeBench i Codeforces, modele destylowane DeepSeek-R1 działały podobnie jak O1-Mini i GPT-4O, wykazując silne możliwości rozumowania w programowaniu. Jednak większe modele nadal mają przewagę w zadaniach wymagających szerszego zrozumienia lub obsługi długich okien kontekstowych, ponieważ mniejsze modele są bardziej specyficzne dla zadania.

Pomimo ich mocnych stron małe modele mogą zmagać się z rozszerzonymi zadaniami rozumowania lub w obliczu danych poza dystrybucją. Na przykład w symulacjach szachowych LLM DeepSeek-R1 popełnił więcej błędów niż większe modele, co wskazuje na ograniczenia jego zdolności do utrzymania skupienia i dokładności w dłuższych okresach.

Kompromisy i praktyczne implikacje

Kompromisy między wielkością modelu a wydajnością mają kluczowe znaczenie przy porównaniu SRMS z LRM na poziomie GPT. Mniejsze modele wymagają mniej pamięci i mocy obliczeniowej, dzięki czemu są idealne do urządzeń krawędziowych, aplikacji mobilnych lub sytuacji, w których konieczne jest wnioskowanie offline. Ta wydajność powoduje niższe koszty operacyjne, przy czym modele takie jak Deepseek-R1 są do 96% tańsze w uruchomieniu niż większe modele, takie jak O1.

Jednak te przyrosty wydajności wiążą się z niektórymi kompromisami. Mniejsze modele są zazwyczaj dopracowane do określonych zadań, które mogą ograniczyć ich wszechstronność w porównaniu z większymi modelami. Na przykład, podczas gdy DeepSeek-R1 wyróżnia się matematyką i kodowaniem, brakuje mu możliwości multimodalnych, takich jak zdolność do interpretacji obrazów, które mogą obsługiwać większe modele, takie jak GPT-4O.

Pomimo tych ograniczeń praktyczne zastosowania małych modeli rozumowania są obszerne. W opiece zdrowotnej mogą one zasilać narzędzia diagnostyczne, które analizują dane medyczne na standardowych serwerach szpitalnych. W edukacji mogą być wykorzystywane do opracowania spersonalizowanych systemów korepetycji, zapewniając studentom opinie krok po kroku. W badaniach naukowych mogą pomóc w analizie danych i testowaniu hipotez w dziedzinach takich jak matematyka i fizyka. Natura modeli, takich jak Deepseek-R1, sprzyja również współpracy i demokratyzuje dostęp do AI, umożliwiając mniejszym organizacjom korzystanie z zaawansowanych technologii.

Dolna linia

Ewolucja modeli językowych w mniejsze modele rozumowania stanowi znaczący postęp w AI. Chociaż modele te mogą jeszcze nie w pełni pasować do szerokich możliwości dużych modeli językowych, oferują kluczowe zalety w zakresie wydajności, opłacalności i dostępności. Uderzając równowagę między mocą rozumowania a wydajnością zasobów, mniejsze modele są gotowe odgrywać kluczową rolę w różnych zastosowaniach, dzięki czemu AI jest bardziej praktyczne i zrównoważone do użytku w świecie rzeczywistym.

-

1

Stardew Valley: Kompletny przewodnik po zaklęciach i wykuwaniu broni

Jan 07,2025

-

2

Roblox Ograniczone kody UGC zaprezentowane na styczeń 2025 r

Jan 06,2025

-

3

Pokémon TCG Pocket: Rozwiązywanie błędu 102 rozwiązane

Jan 08,2025

-

4

Blue Archive Ogłasza marcowe wydarzenie CyberNowego Roku

Dec 19,2024

-

5

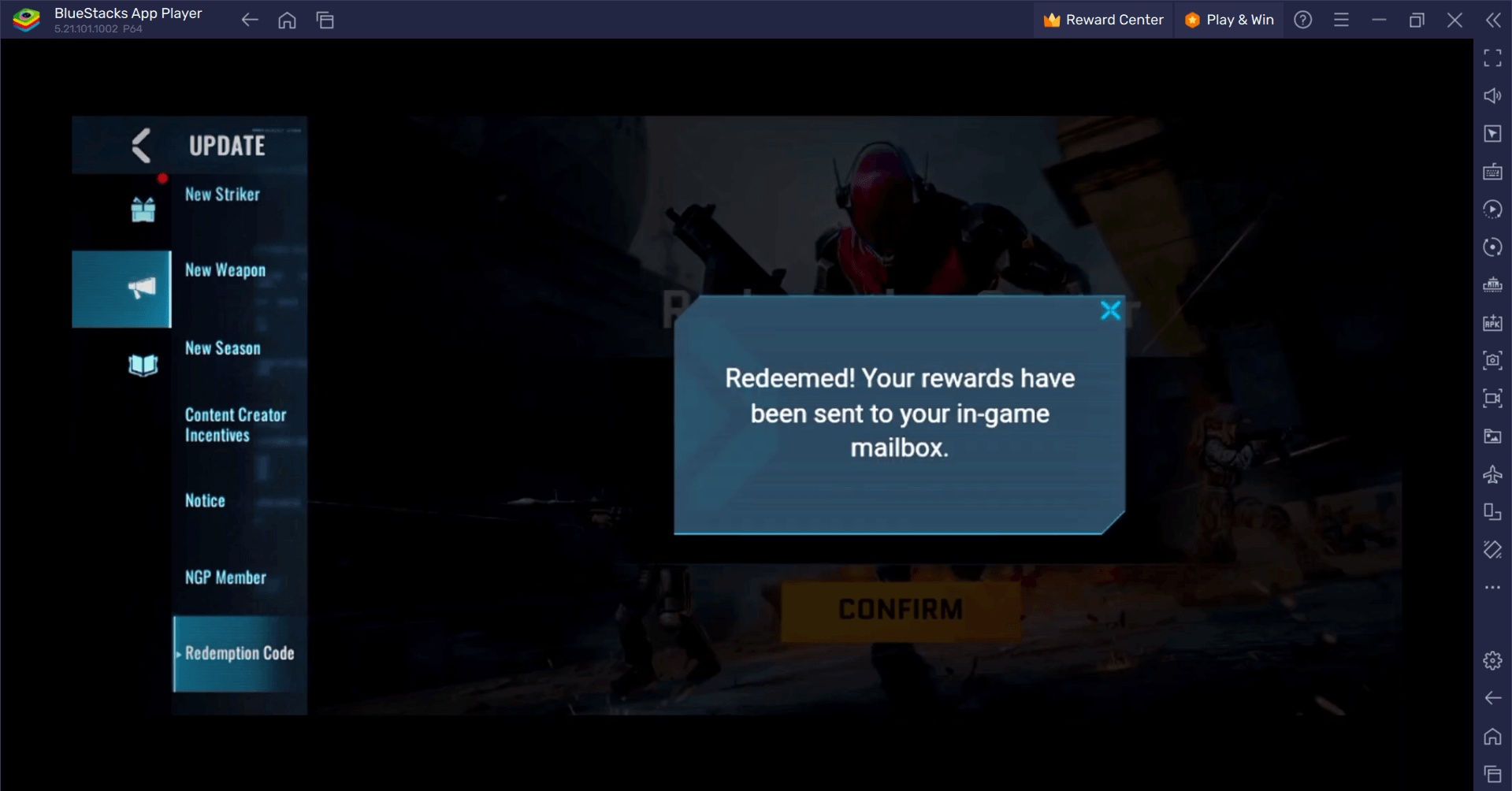

Blood Strike — wszystkie działające kody realizacji, styczeń 2025 r

Jan 08,2025

-

6

Cyber Quest: Weź udział w wciągających bitwach karcianych na Androidzie

Dec 19,2024

-

7

![Lista warstwy znaków Roblox Forsaken [zaktualizowana] (2025)](https://imgs.ksjha.com/uploads/18/17380116246797f3e8a8a39.jpg)

Lista warstwy znaków Roblox Forsaken [zaktualizowana] (2025)

Mar 17,2025

-

8

Bart Bonte upuszcza nową łamigłówkę Mister Antonio, w której grasz w aportowanie „dla” kota!

Dec 18,2024

-

9

Sony Ujawnia nowe Midnight czarne akcesoria do PS5

Jan 08,2025

-

10

Roblox: Kody RIVALS (styczeń 2025)

Jan 07,2025

-

Pobierać

Random fap scene

Zwykły / 20.10M

Aktualizacja: Dec 26,2024

-

Pobierać

![Corrupting the Universe [v3.0]](https://imgs.ksjha.com/uploads/66/1719514653667db61d741e9.jpg)

Corrupting the Universe [v3.0]

Zwykły / 486.00M

Aktualizacja: Dec 17,2024

-

Pobierać

Arceus X script

Personalizacja / 127.00M

Aktualizacja: Oct 21,2021

-

4

A Simple Life with My Unobtrusive Sister

-

5

Ben 10 A day with Gwen

-

6

A Wife And Mother

-

7

Permit Deny

-

8

Oniga Town of the Dead

-

9

Cute Reapers in my Room Android

-

10

Piano White Go! - Piano Games Tiles